-

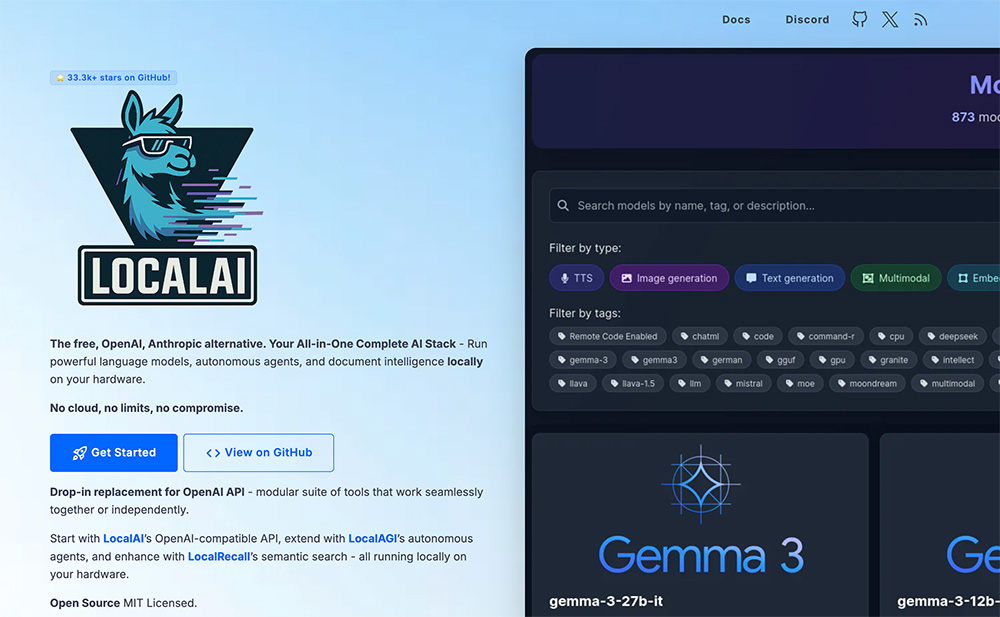

- AI创新应用LocalAI支持文本生成、图像生成、语音转文字、文本转语音等多种多模态功能。

爱站权重:

LocalAI是开源本地AI推理框架,提供完整本地化AI解决方案,支持文本生成、图像生成、语音处理等多模态功能,兼容OpenAI API,所有数据处理均在本地完成,保障隐私安全。其适配CPU及NVIDIA、AMD、Intel等品牌GPU,支持GGML、GGUF、GPTQ等多种模型格式,部署灵活,还包含LocalAGI(自主AI代理)、LocalRecall(语义搜索)等组件,适用于多AI功能需求项目。

LocalAI核心功能:

1、多模态支持:覆盖文本生成、图像生成、语音转文字、文本转语音等功能,例如可将实验数据自动转化为可视化图表。

2、OpenAI API兼容性:提供兼容的REST接口,现有应用无需修改代码,即可无缝替换OpenAI服务实现本地化部署。

3、本地推理与隐私保护:所有AI推理和数据处理均在本地完成,敏感信息不上云、不通过网络传输,杜绝外泄风险。

4、广泛硬件适配:支持纯CPU运行,也兼容NVIDIA、AMD、Intel的GPU,适配不同硬件配置需求。

5、WebUI与模型管理:提供Web图形用户界面,方便模型管理、文件处理和实时对话;通过gRPC接口支持模型加载,预加载常用模型可降低首次推理延迟。

6、工具调用与集成:支持函数调用和嵌入服务,便于开发者将AI功能集成到现有系统中。

LocalAI技术原理:

1、基于开源库构建:依托llama.cpp、gpt4all.cpp实现文本生成,whisper.cpp完成音频转录,Stable Diffusion负责图像生成,整合多款开源工具实现多元功能。

2、兼容OpenAI API规范:通过对接该规范,实现与现有系统无缝对接,可直接作为OpenAI替代品本地运行,无需改动代码。

3、多硬件适配技术:支持CPU及多品牌GPU,借助量化技术(如ggml/q4_0),让大型模型能在消费级硬件上高效运行。

4、分布式推理架构:基于P2P网络实现分布式推理,通过mDNS和DHT协议完成节点发现,libp2p协议栈保障通信加密安全。

5、动态任务调度:采用去中心化设计,根据节点CPU/内存使用率、网络延迟动态分配任务,优先选择低负载节点,提升集群可用性和容错能力。

LocalAI应用场景:

1、企业内网环境:搭建私有AI助手,处理内部文档、代码审查、知识问答等任务,保障企业敏感数据安全。

2、个人开发环境:作为本地AI编程助手,快速响应代码相关需求,减少网络延迟,提升开发效率。

3、离线AI应用:在无网络场景下,支持离线科研、编程、内容创作等AI相关操作。

4、自主AIAgent:本地构建部署自主Agent,实现任务自动化和复杂工作流,不依赖云端服务。

5、语义检索与记忆:搭建本地知识库和语义检索系统,增强AI的上下文感知能力和持久记忆能力。

6、多模态内容生成:本地完成文本、图像、音频生成,适配创意项目、市场营销、多媒体制作等场景。

数据统计

特别声明&浏览提醒

本站AI工具导航站提供的「LocalAI」的相关内容都来源于网络,不保证外部链接的准确性和完整性。在2025年11月09日 20时42分21秒收录时,该网站上的内容都属于合规合法,后期网站的内容如出现违规,可以直接联系网站管理员(ai@ipkd.cn)进行删除,AI工具导航站不承担任何责任。在浏览网页时,请注意您的账号和财产安全,切勿轻信网上广告!

10款免费AI数据分析神器,一键生成,轻松搞定数据难题!

10款免费AI数据分析神器,一键生成,轻松搞定数据难题! 盘点8款高效AI搜索工具,助力智能信息检索

盘点8款高效AI搜索工具,助力智能信息检索 6款免费AI Logo生成器,快速打造专业品牌标志!

6款免费AI Logo生成器,快速打造专业品牌标志! 5款AI老照片修复工具,轻松去除图片和视频马赛克

5款AI老照片修复工具,轻松去除图片和视频马赛克 9款免费AI论文写作工具,高效助力学术创作

9款免费AI论文写作工具,高效助力学术创作 6款免费好用的AI文本转语音工具,智能合成超逼真配音

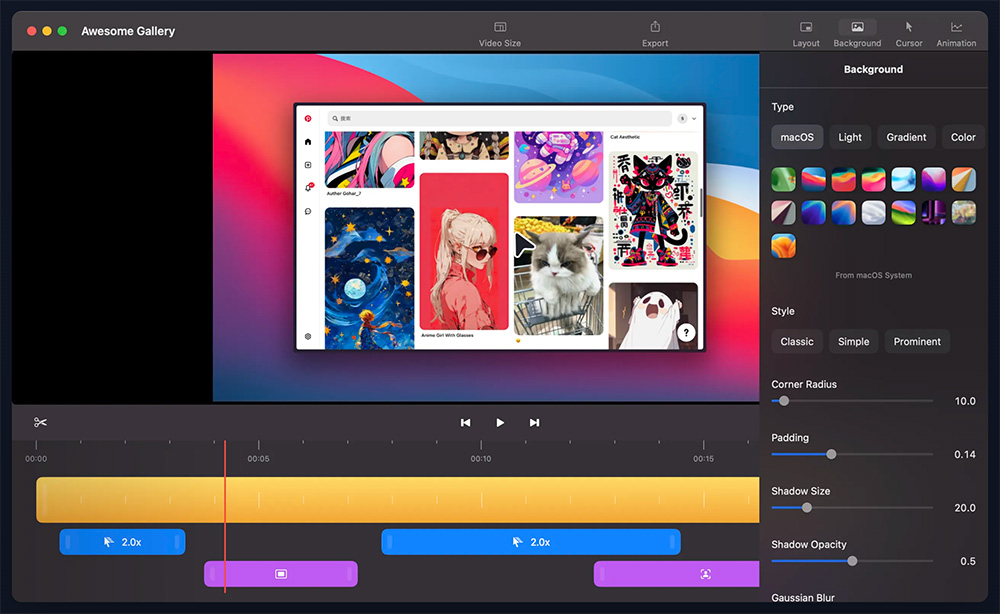

6款免费好用的AI文本转语音工具,智能合成超逼真配音 目前国内最火好用的ai视频软件有哪些 2025流行的AI视频软件排行榜

目前国内最火好用的ai视频软件有哪些 2025流行的AI视频软件排行榜 8款二次元AI绘画工具,一键生成动漫风插画,免费试用!

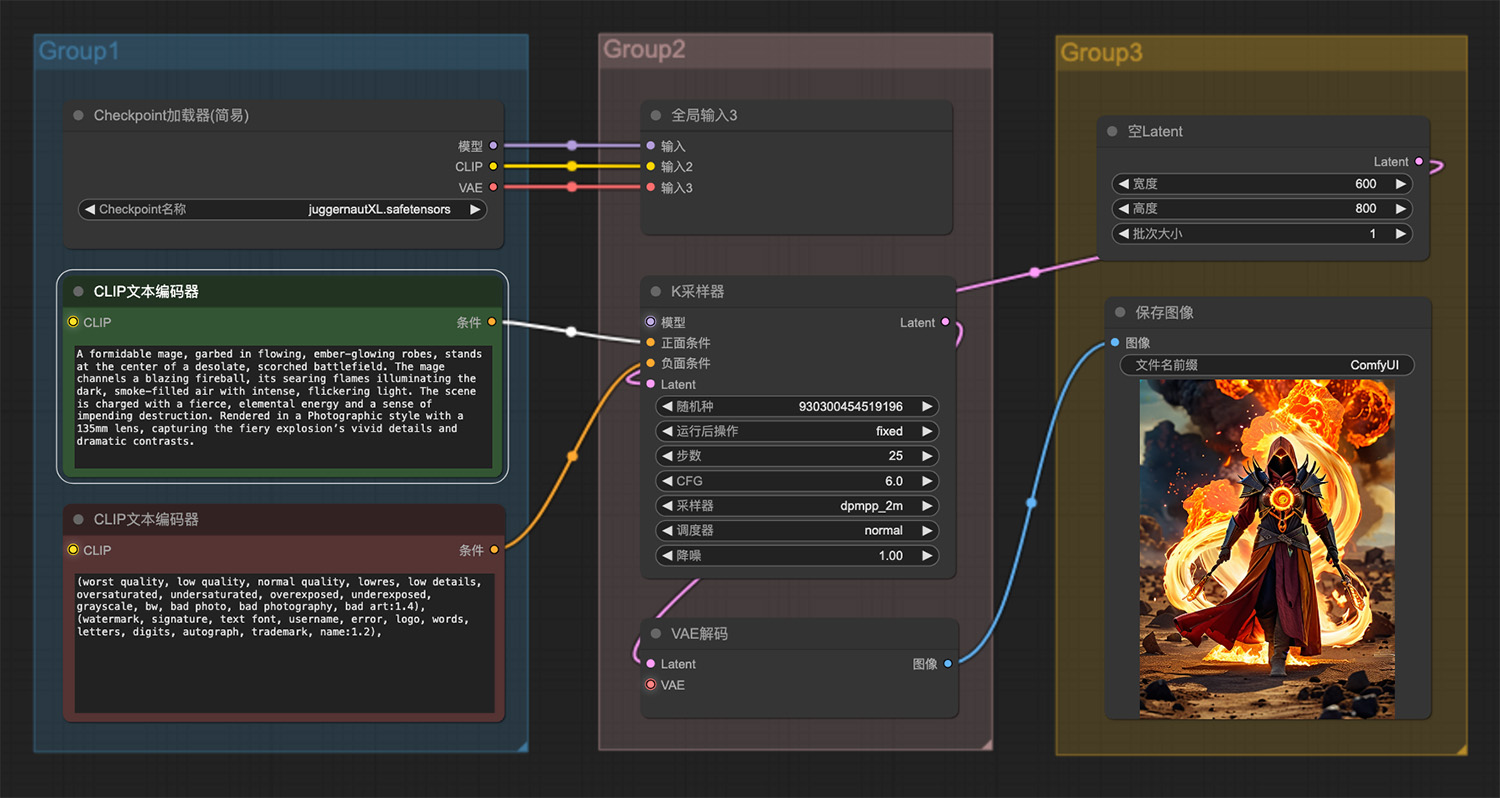

8款二次元AI绘画工具,一键生成动漫风插画,免费试用! 一位穿着长袍的强大法师ComfyUI工作流

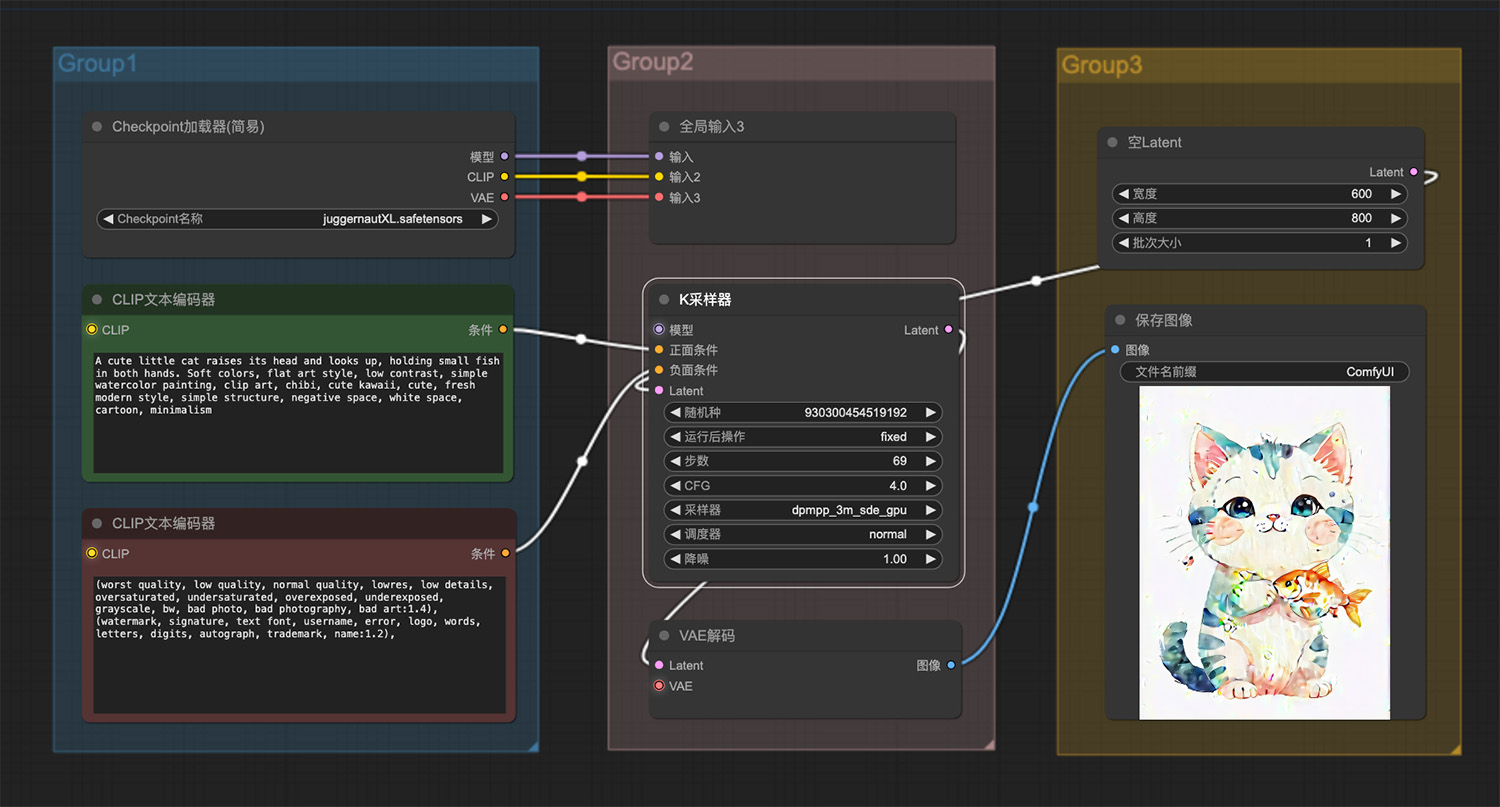

一位穿着长袍的强大法师ComfyUI工作流 一只猫捧着一条鱼ComfyUI工作流

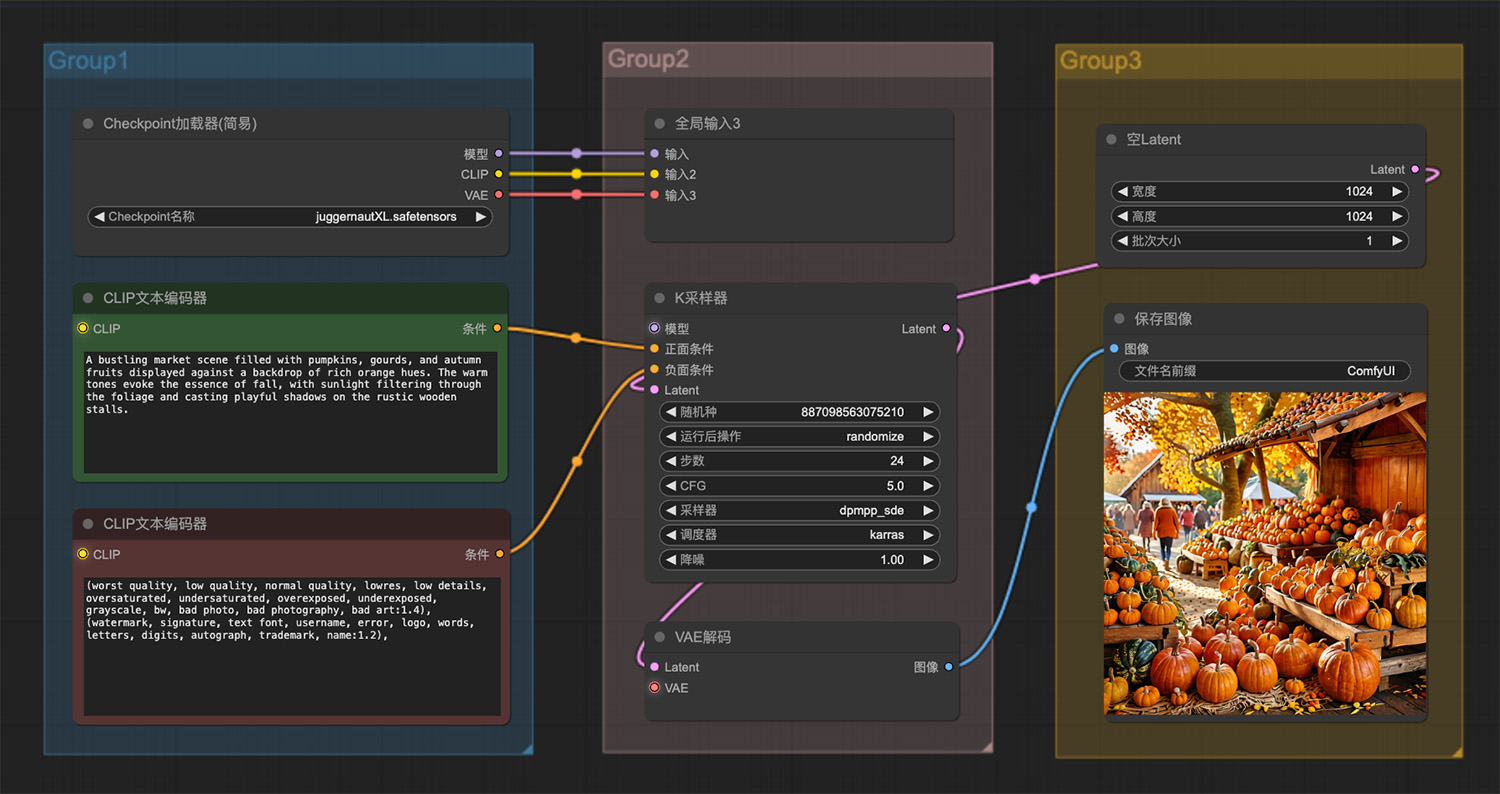

一只猫捧着一条鱼ComfyUI工作流 一个熙熙攘攘的市场场景,里面摆满了南瓜

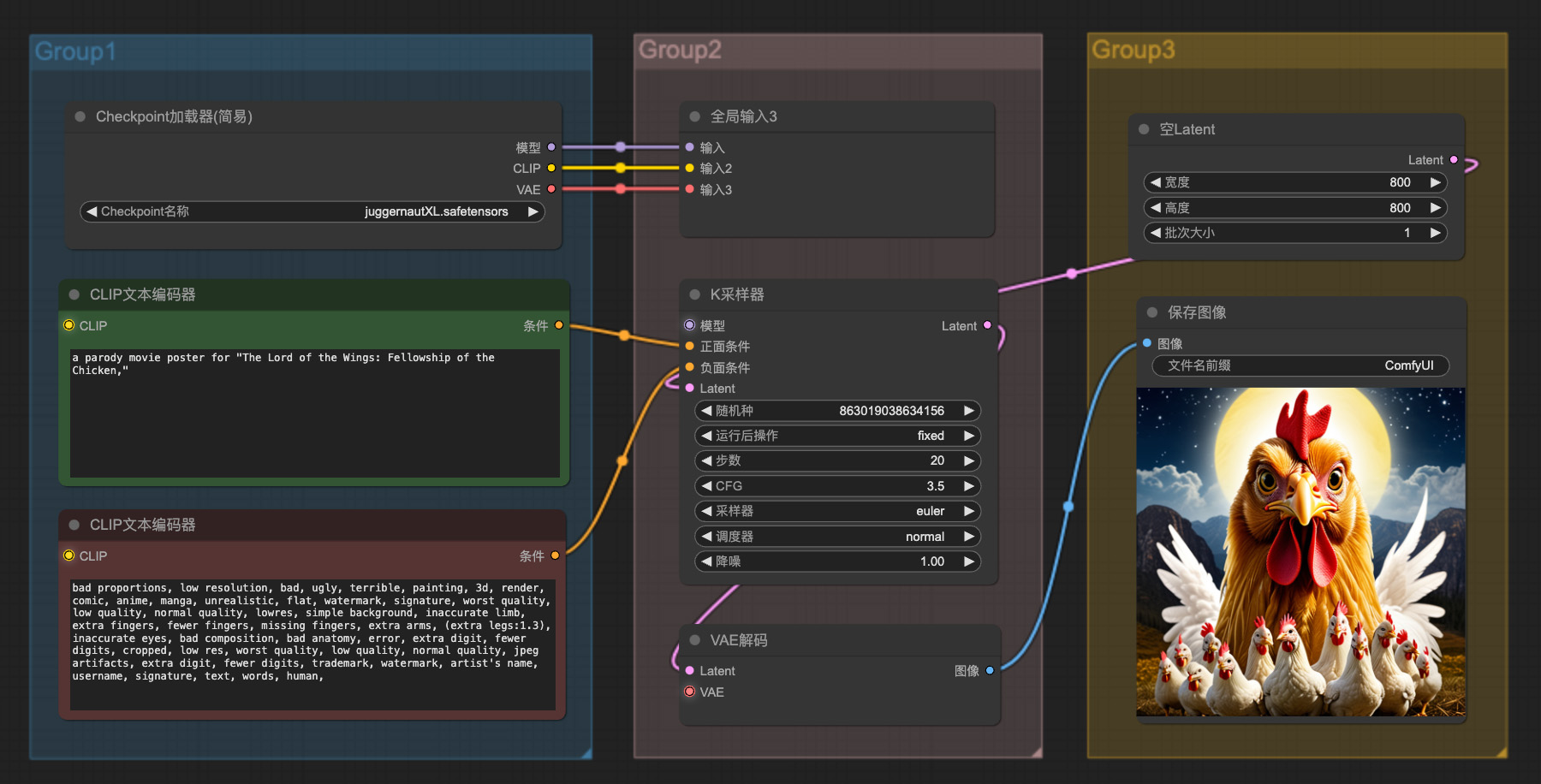

一个熙熙攘攘的市场场景,里面摆满了南瓜 《翅膀之王:鸡的团契》海报ComfyUI工作流

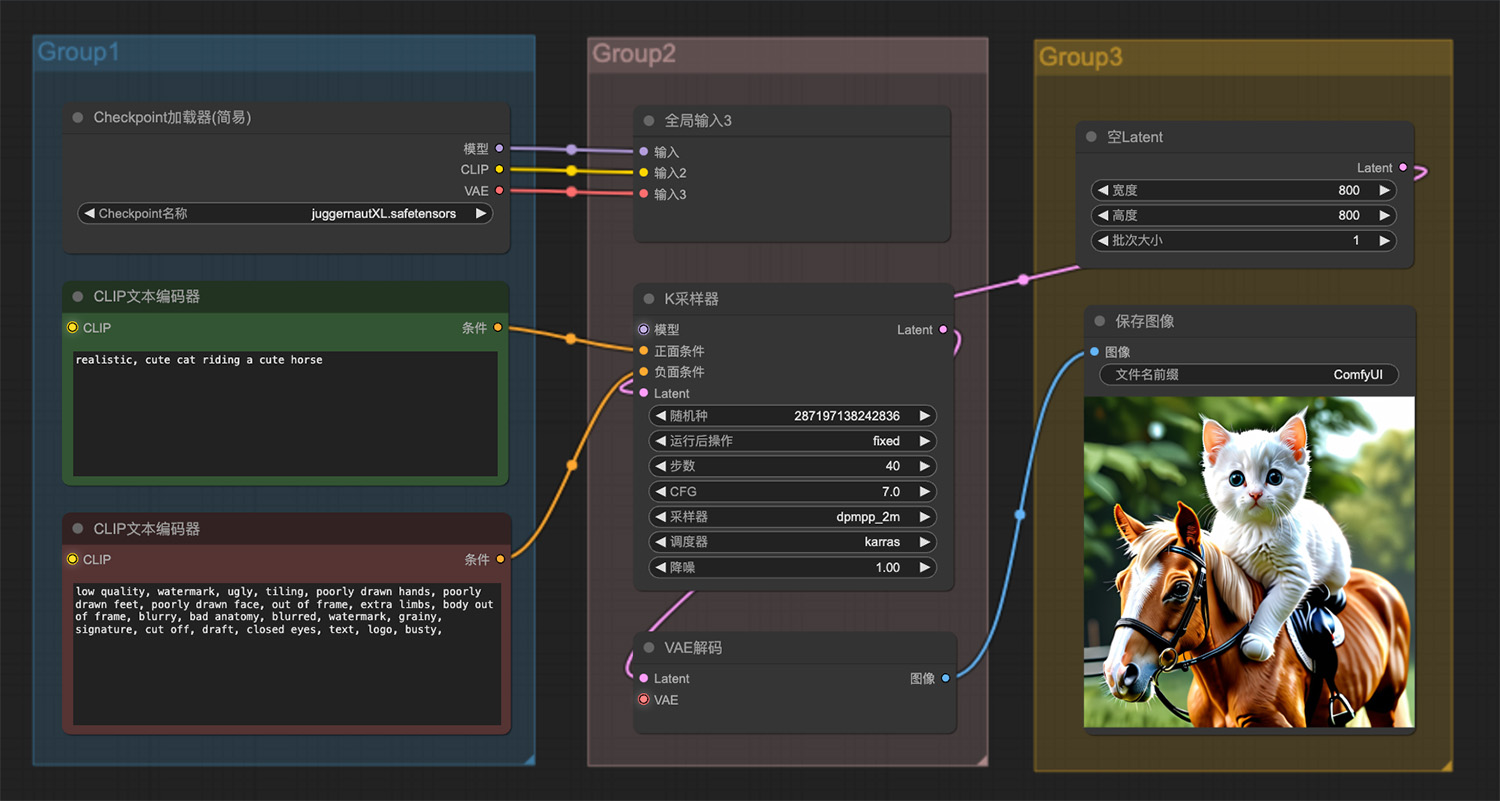

《翅膀之王:鸡的团契》海报ComfyUI工作流 一只可爱的猫骑着一匹可爱的马ComfyUI工作流

一只可爱的猫骑着一匹可爱的马ComfyUI工作流 一张超现实主义美女照片ComfyUI工作流

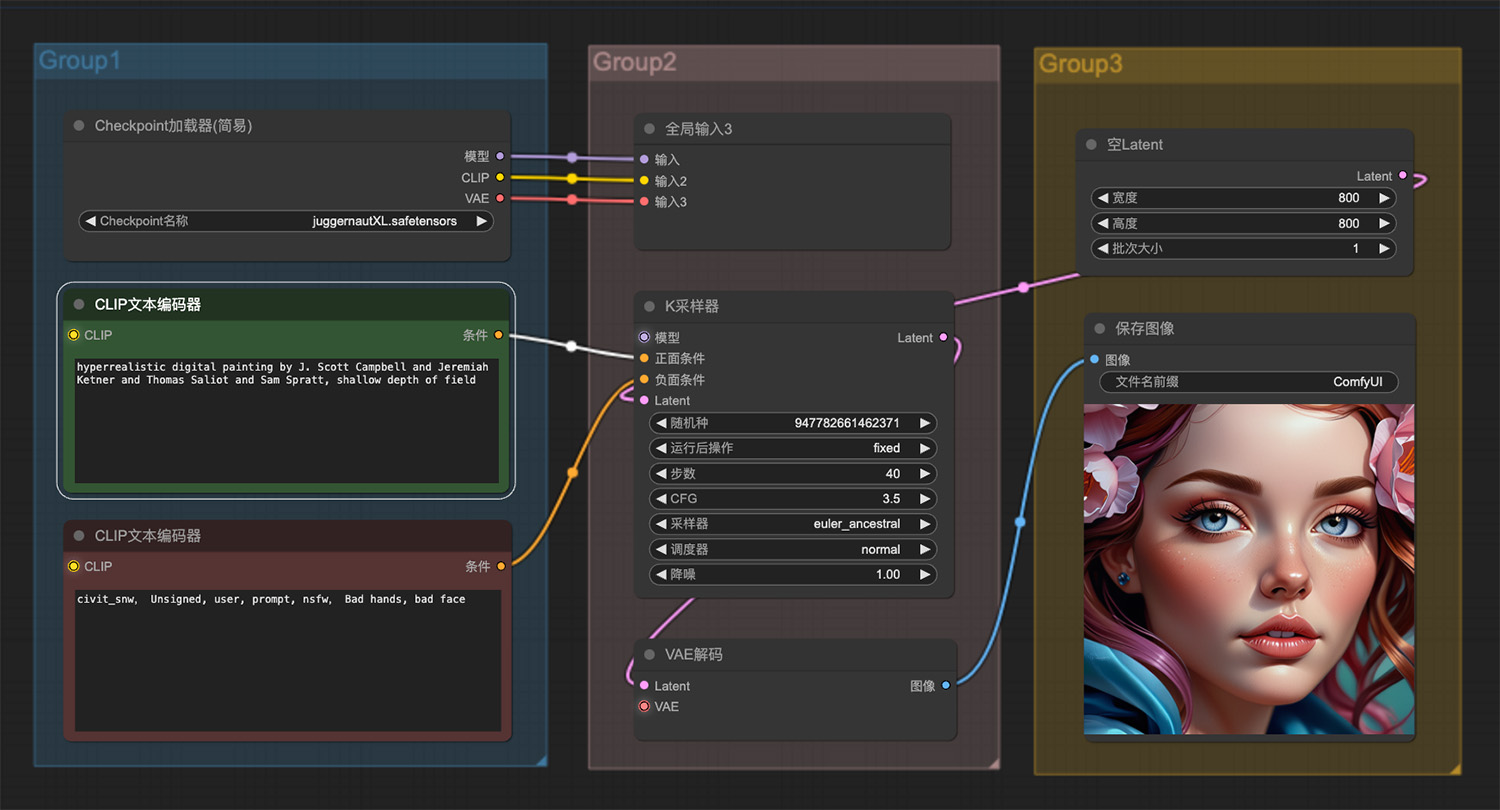

一张超现实主义美女照片ComfyUI工作流 一个时间旅行女人的神秘剪影ComfyUI工作流

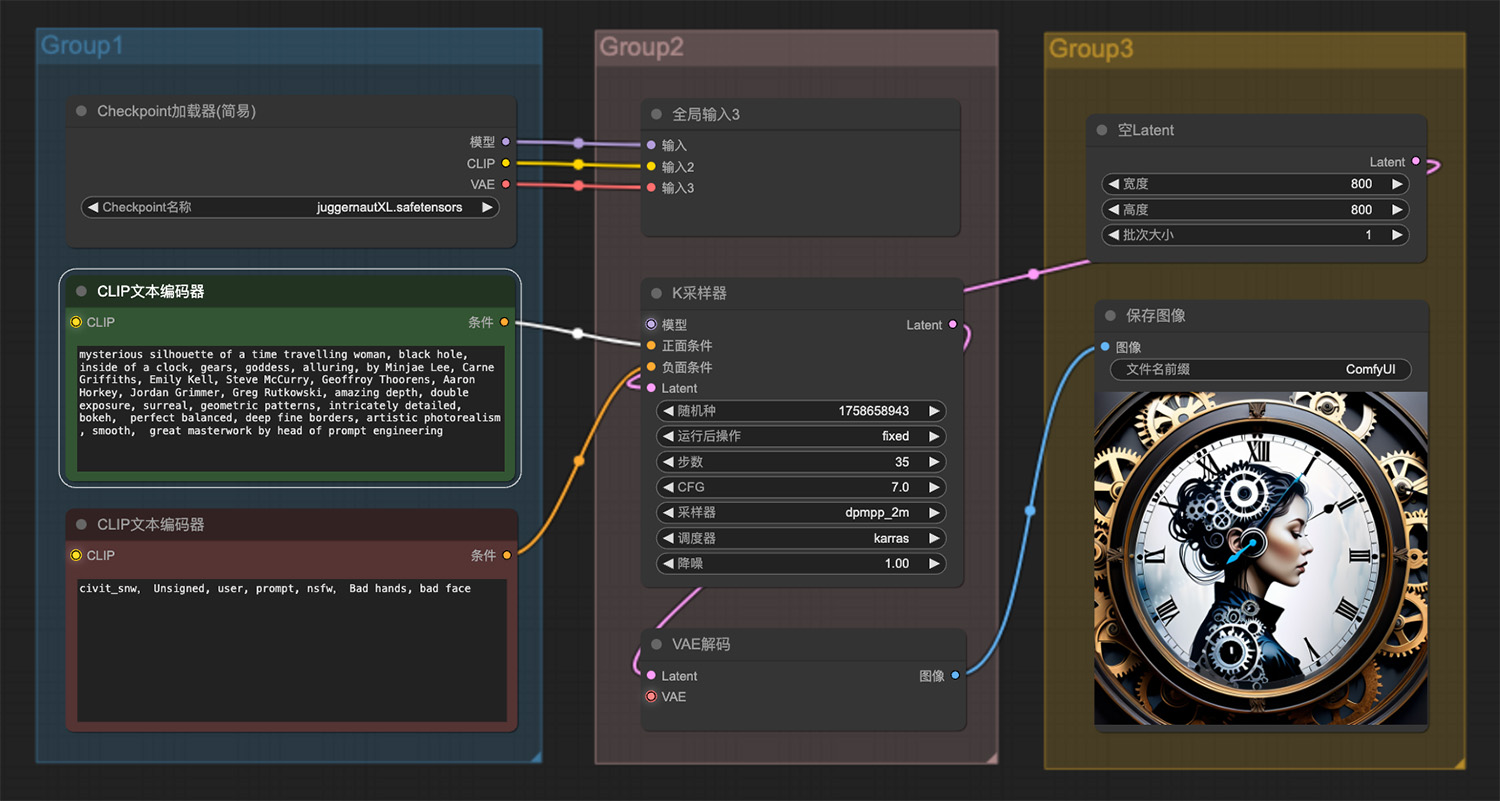

一个时间旅行女人的神秘剪影ComfyUI工作流 树上挂着一只表情可爱的香蕉ComfyUI工作流二

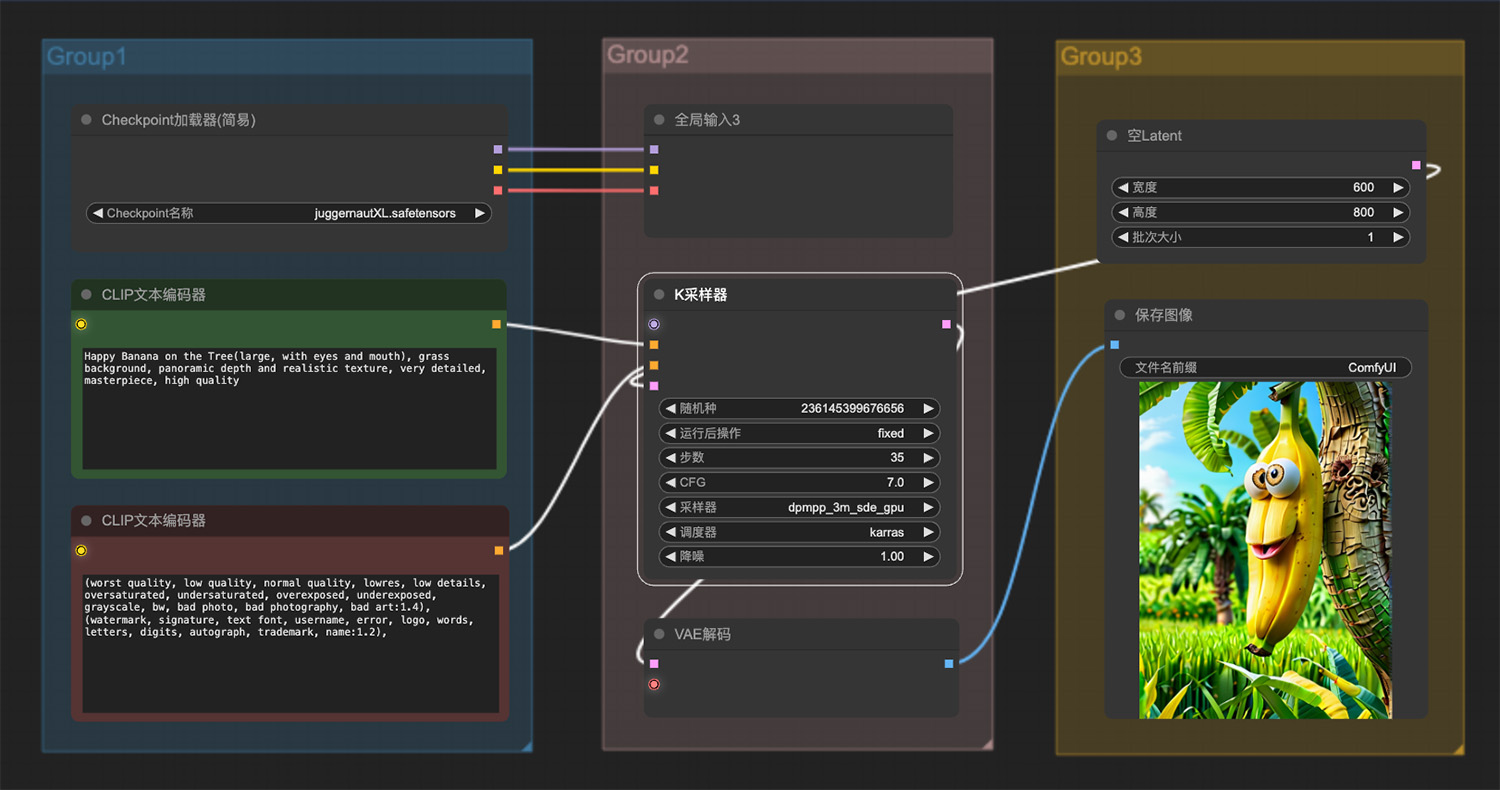

树上挂着一只表情可爱的香蕉ComfyUI工作流二 即梦AI绘画网页版

即梦AI绘画网页版 BaruaAI

BaruaAI 爱派AiPy

爱派AiPy 红薯通AI

红薯通AI OpenAI

OpenAI ThinkAny

ThinkAny Apache MXNet

Apache MXNet 捏TA

捏TA

豆包在线网页版

豆包在线网页版 功夫量化

功夫量化 Last24 AI

Last24 AI 高考志愿大模型

高考志愿大模型 代悟AI搜索

代悟AI搜索 Nvidia·GET3D

Nvidia·GET3D