-

- AI创新应用LLaMALLaMA是一组基础语言模型集合,参数规模从7亿到650亿不等,涵盖了不同的版本如7B、13B、33B、65B等。

爱站权重:

LLaMA是一组基础语言模型集合,参数规模从7亿到650亿不等,涵盖了不同的版本如7B、13B、33B、65B等。这些模型在数万亿个token上进行训练,展示了使用公开数据集也能达到先进水平的能力。

LLaMA官方网址入口:https://llama.meta.com(需要科学上网)

LLaMA项目网址入口:https://github.com/meta-llama/llama

LLaMA主要功能特点介绍

1、高效性:

LLaMA模型基于Transformer架构,并对标准的Transformer架构进行了改进以提高训练稳定性。其结构包括编码器(Encoder)、任务适配器(TaskAdapter)和解码器(Decoder),其中TaskAdapter的门控机制能动态适应不同任务。

2、开源性:

作为第一个向学术界开源的大规模语言模型,LLaMA的所有版本均已开源,这使得研究人员和开发者能够自由地使用和修改这些模型。

3、广泛的应用领域:

LLaMA在文本分类、序列标注、机器翻译等领域有广泛应用,并且在智能客服、内容推荐等方面表现出色。例如,在智能客服系统中,LLaMA可以实现自动回答用户问题并提供个性化服务。

4、性能优势:

尽管参数规模较小,但LLaMA在逻辑推理和代码生成方面表现优于GPT-3、LaMDA和PaLM等模型。此外,LLaMA-13B在大多数基准测试中优于GPT-3,并且在常识推理任务中取得了更好的结果。

5、训练数据丰富多样:

LLaMA的训练数据来自各种公开可用的数据集,包括Common Crawl、C4、GitHub、Wikipedia、书库和ArXiv等。

6、灵活性与可扩展性:

LLaMA模型可以根据任务调整结构和参数,从而提高泛化能力和效率。这种灵活性使其能够在多种应用场景下发挥重要作用。

LLaMA不仅是一个高性能的语言模型,而且通过开源和灵活的特性,为研究人员和开发者提供了强大的工具,推动了自然语言处理技术的发展。

数据统计

特别声明&浏览提醒

本站AI工具导航站提供的「LLaMA」的相关内容都来源于网络,不保证外部链接的准确性和完整性。在2024年09月02日 21时17分17秒收录时,该网站上的内容都属于合规合法,后期网站的内容如出现违规,可以直接联系网站管理员(ai@ipkd.cn)进行删除,AI工具导航站不承担任何责任。在浏览网页时,请注意您的账号和财产安全,切勿轻信网上广告!

10款免费AI数据分析神器,一键生成,轻松搞定数据难题!

10款免费AI数据分析神器,一键生成,轻松搞定数据难题! 7款免费AI英语口语软件,一对一模拟对话,轻松开口说英语!

7款免费AI英语口语软件,一对一模拟对话,轻松开口说英语! 11款热门AI音乐生成工具,国内外免费资源大推荐!

11款热门AI音乐生成工具,国内外免费资源大推荐! 6款免费好用的AI文本转语音工具,智能合成超逼真配音

6款免费好用的AI文本转语音工具,智能合成超逼真配音 打工人必备!10款浏览器摸鱼插件,轻松应对工作间隙!

打工人必备!10款浏览器摸鱼插件,轻松应对工作间隙! 盘点12款免费的PDF在线转换工具

盘点12款免费的PDF在线转换工具 12款AI数字人制作工具,快速生成口播与直播内容!

12款AI数字人制作工具,快速生成口播与直播内容! 免费AI数据分析神器:一键生成可视化图表,轻松搞定复杂数据

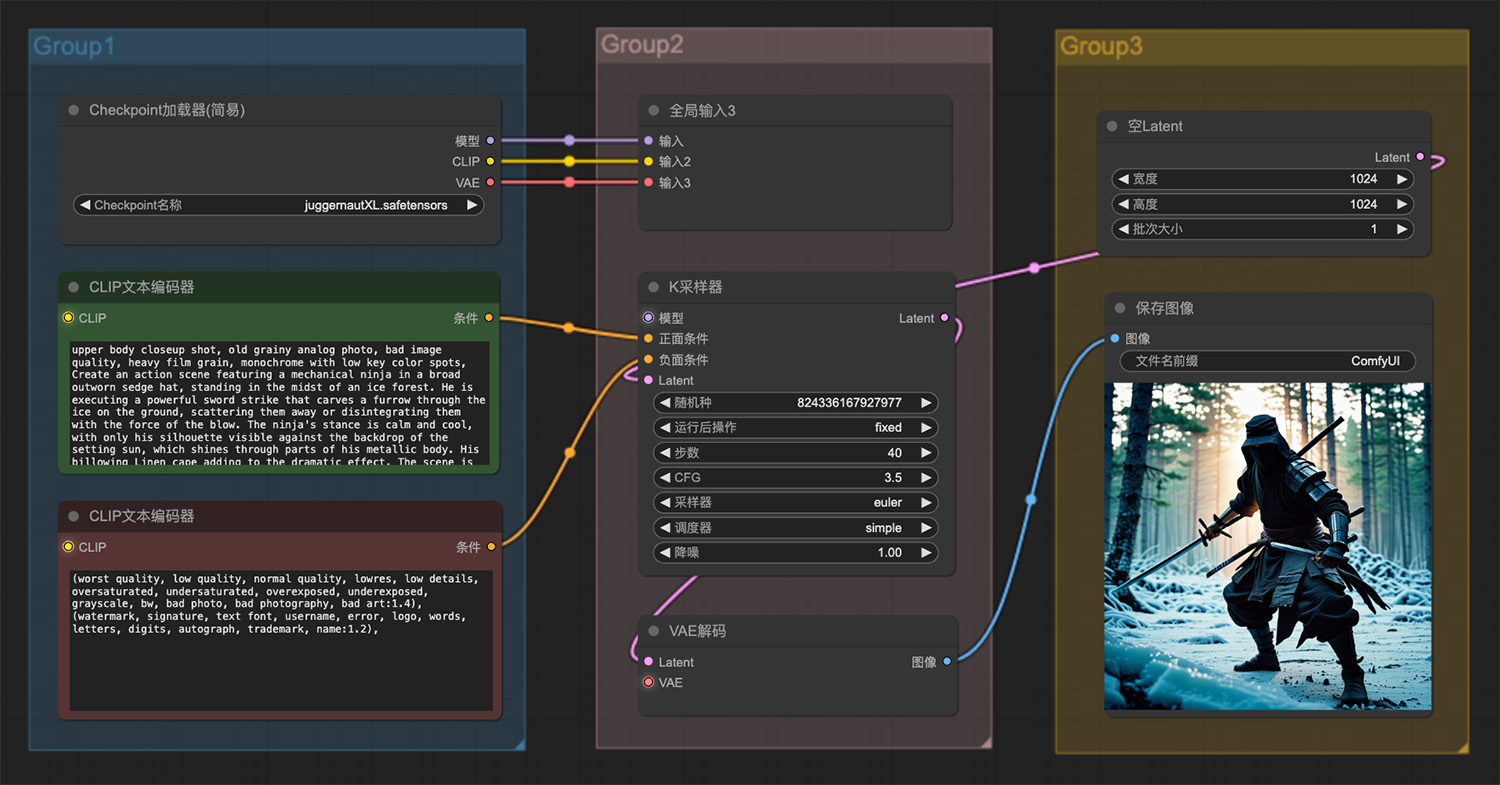

免费AI数据分析神器:一键生成可视化图表,轻松搞定复杂数据 一个戴着破旧莎帽子的机械忍者站在冰林中

一个戴着破旧莎帽子的机械忍者站在冰林中 一位漂亮的女人坐在樱花树旁

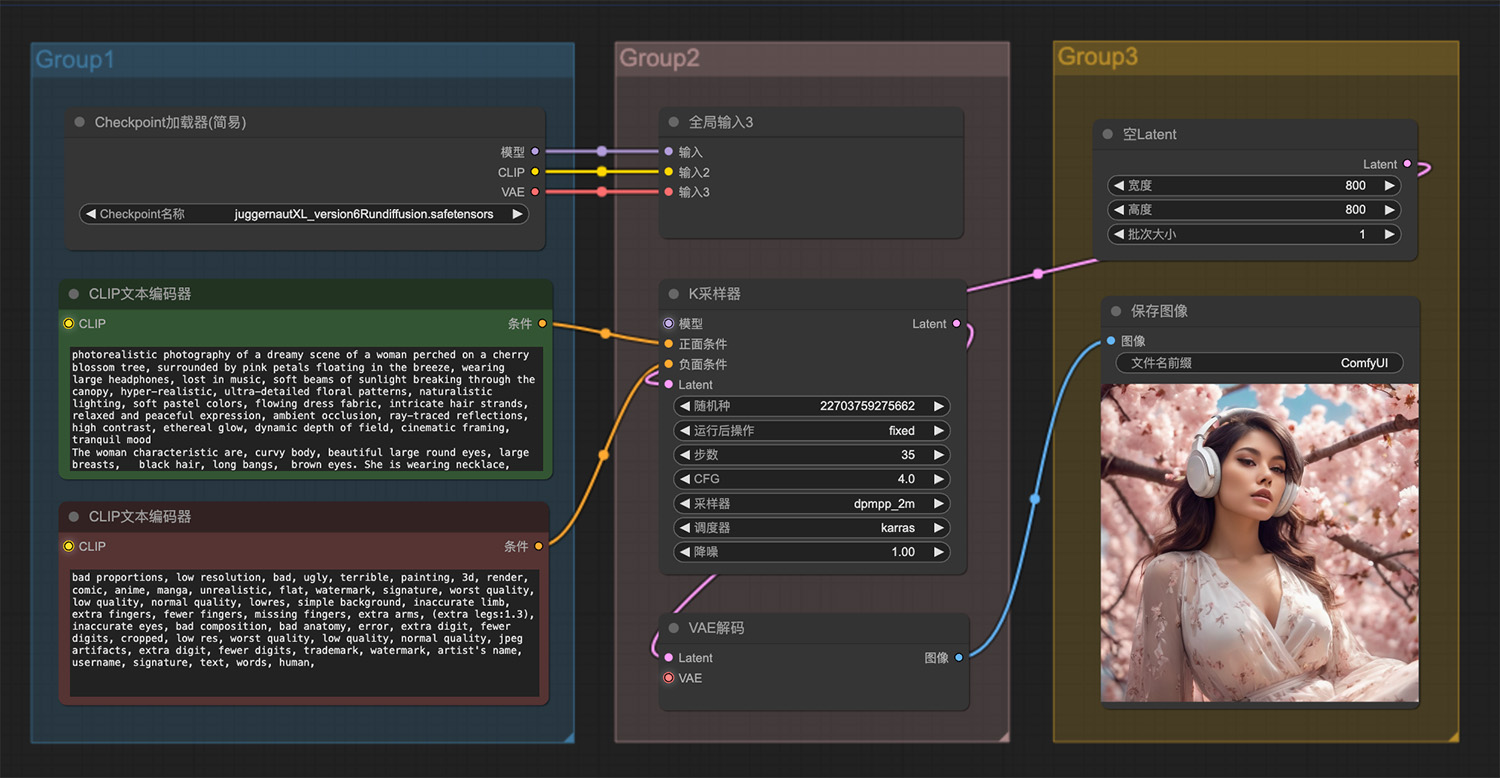

一位漂亮的女人坐在樱花树旁 丛林里坐着一尊佛像

丛林里坐着一尊佛像 一条色彩斑斓的超现实小孔雀鱼ComfyUI工作流

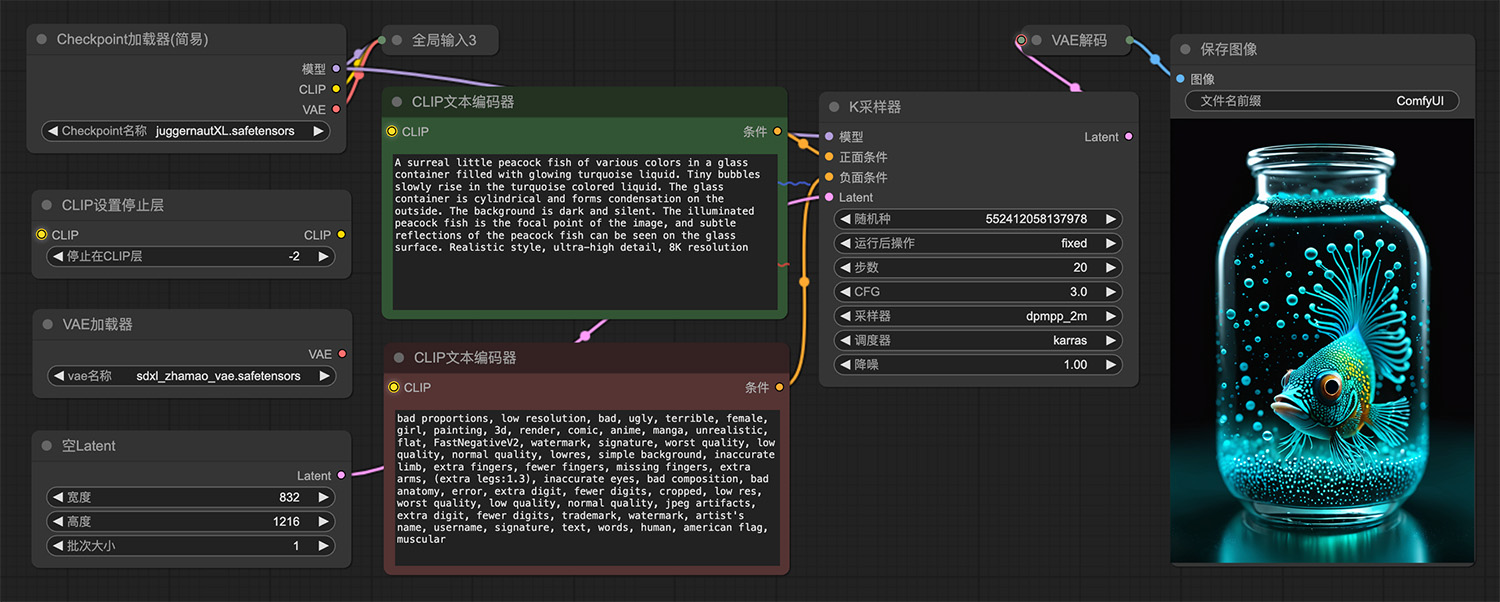

一条色彩斑斓的超现实小孔雀鱼ComfyUI工作流 葡萄庄园白葡萄酒ComfyUI工作流

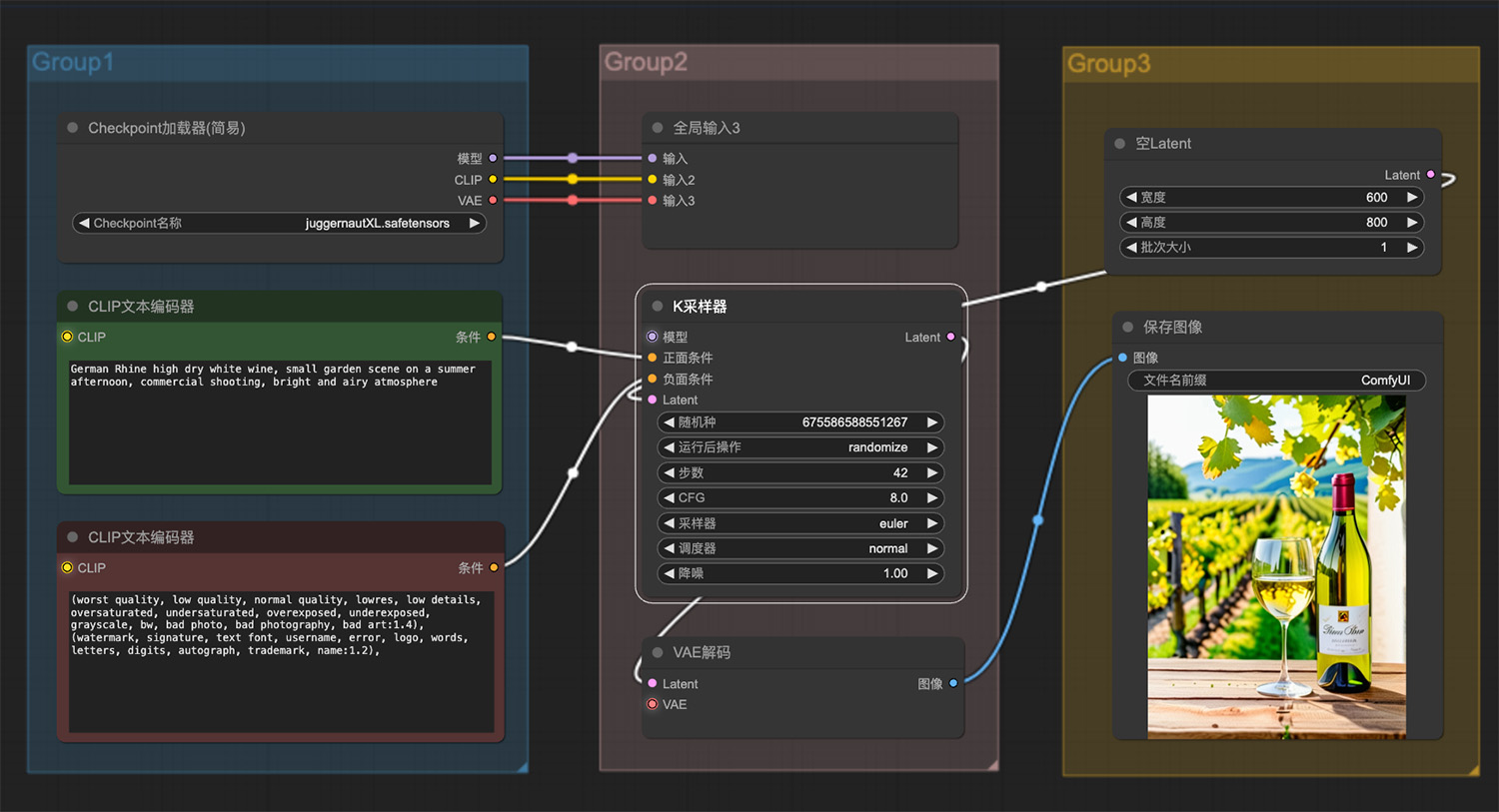

葡萄庄园白葡萄酒ComfyUI工作流 一辆机器人虎狮高端混合动力车ComfyUI工作流

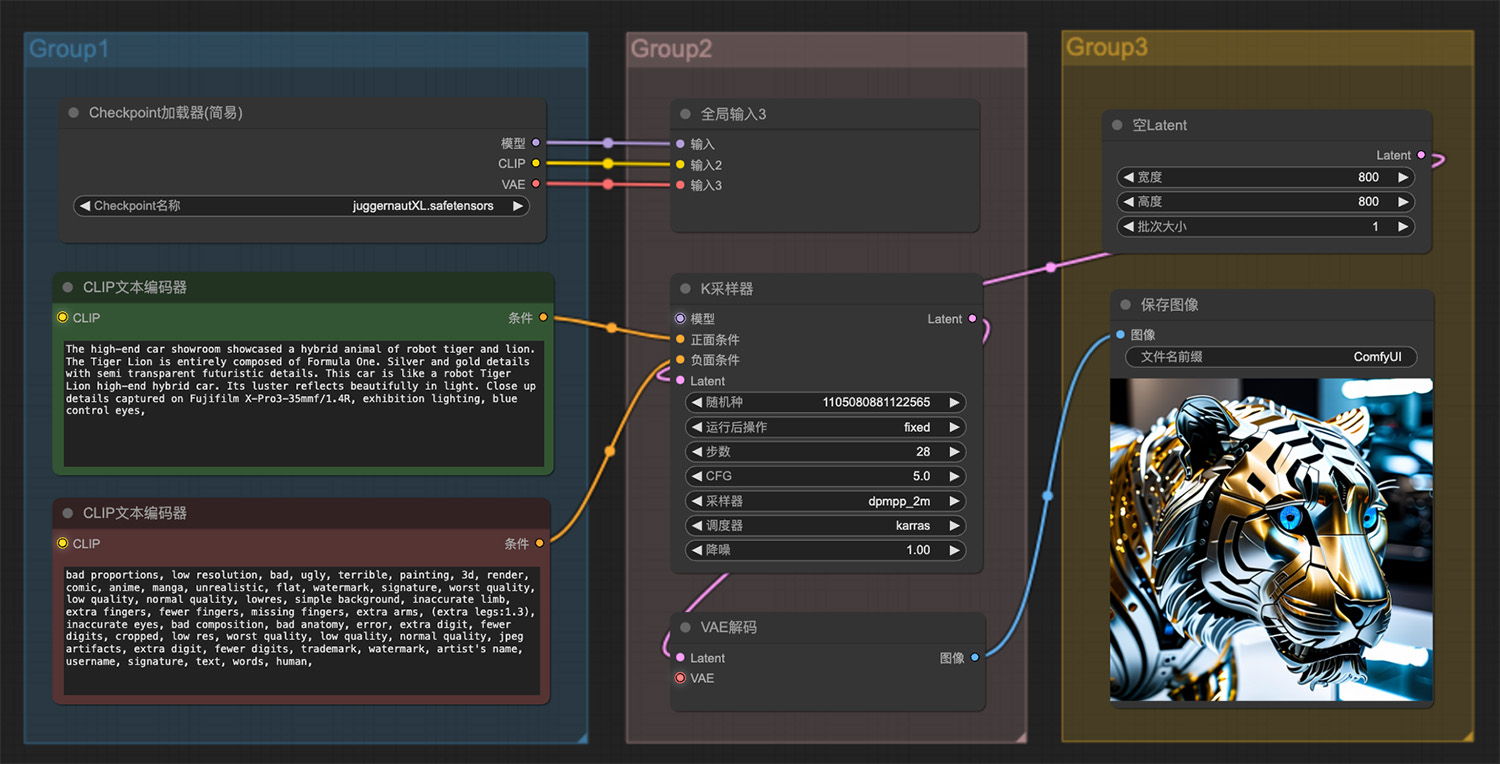

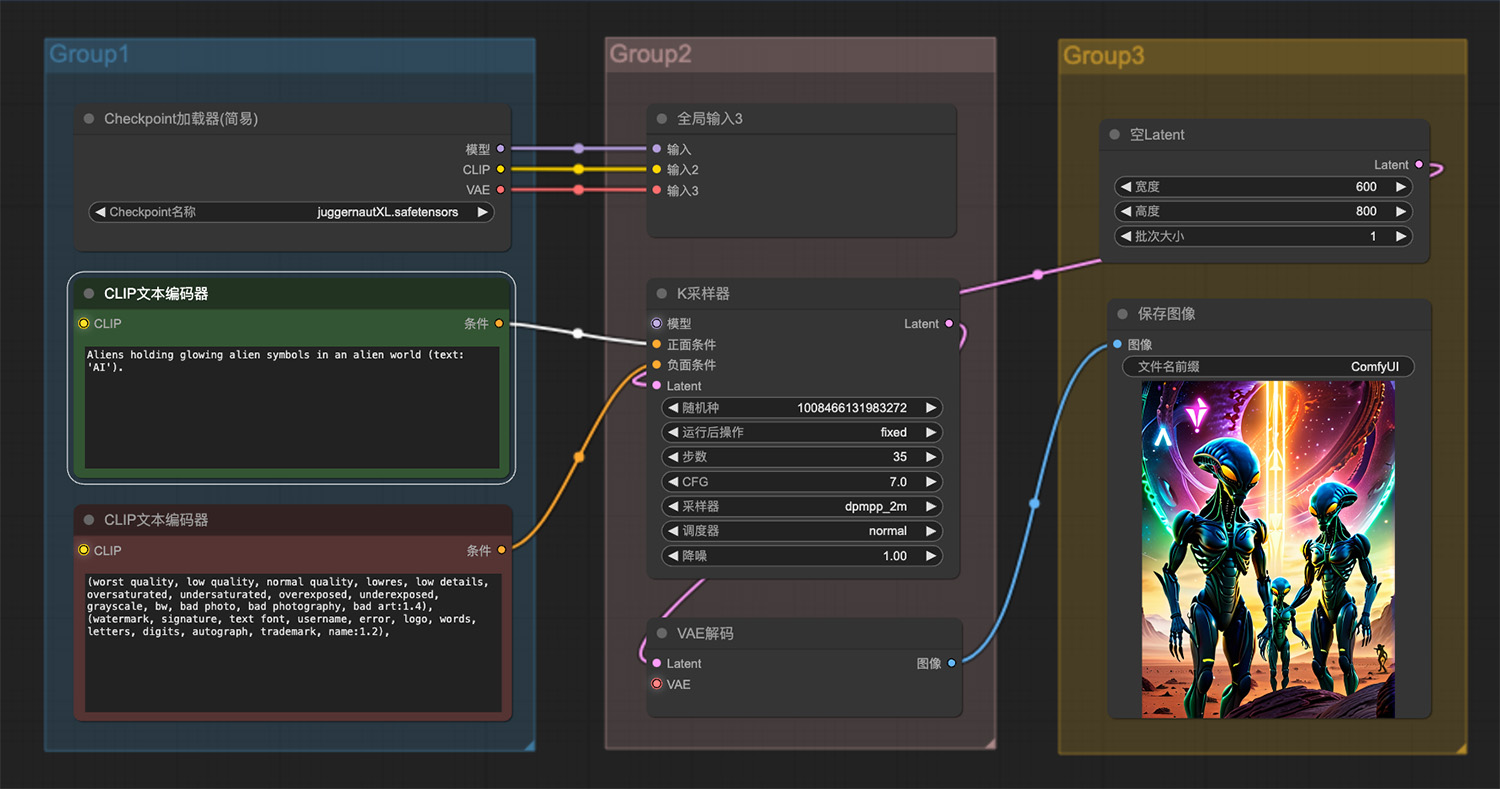

一辆机器人虎狮高端混合动力车ComfyUI工作流 外星人ComfyUI工作流

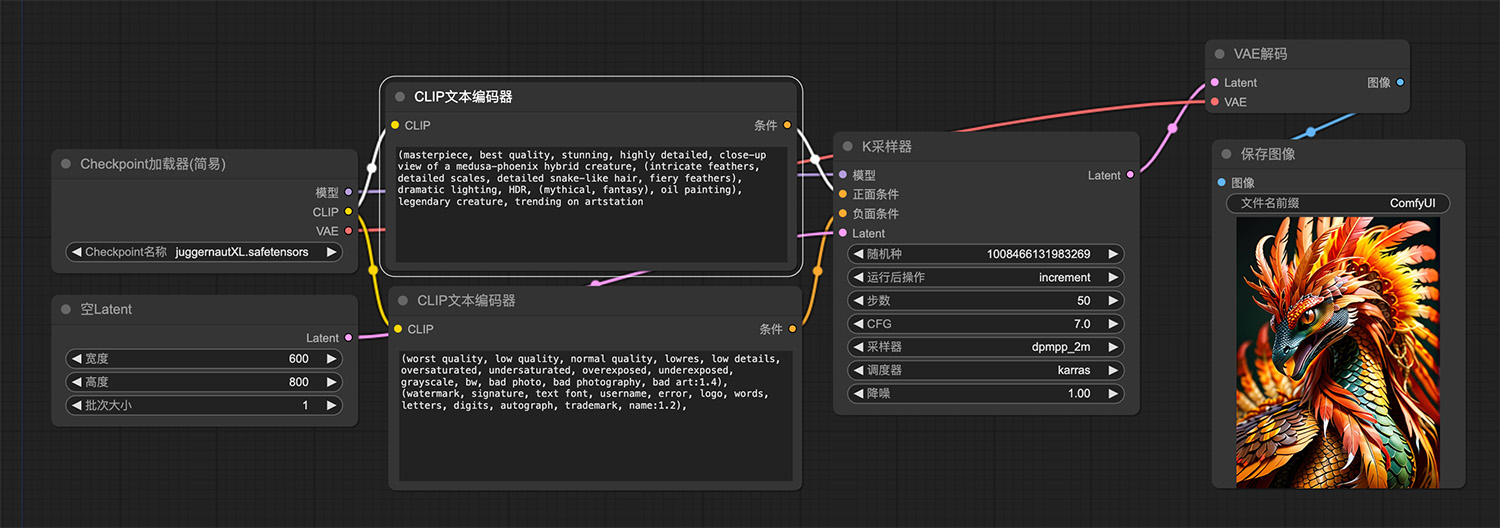

外星人ComfyUI工作流 五彩斑斓的蛇状飞鸟

五彩斑斓的蛇状飞鸟 即梦AI绘画网页版

即梦AI绘画网页版 Neuralink

Neuralink Tidyread

Tidyread Fireflies

Fireflies OpenBMB

OpenBMB 阿里云天池大赛

阿里云天池大赛 智能码AI

智能码AI 同花顺问财

同花顺问财

豆包在线网页版

豆包在线网页版 硅灵Ai

硅灵Ai Codex

Codex MoMask

MoMask Murf.AI

Murf.AI remio

remio