-

Loopy

Loopy

- AI视频创作Loopy通过音频输入生成虚拟人物的多种动作,包括头部、眼睛、眉毛等部位的微表情。

爱站权重:

Loopy是由字节跳动和浙江大学的研究团队共同开发的端到端音频驱动的肖像视频生成模型。它通过音频信号生成动态的肖像视频,能够实现音频与视觉内容的同步。

![]()

Loopy功能特点包括:

1、音频驱动的动态生成:

通过音频输入生成虚拟人物的多种动作,包括头部、眼睛、眉毛等部位的微表情。能够完美适应不同的音频风格,如欢快音乐下人物的活跃动作或舒缓音频中的柔和动作。

2、多样化动作效果:

针对同一参考图像,根据不同的音频输入生成多样化的动作效果,从快速动态到柔和表现不一而足。

3、面部情感同步:

不仅能处理语言表达的情感,还能生成包括叹息等非语言的情感动作。

4、适应各种视觉风格:

可以处理不同角度的图像,即使是侧面图像也能很好地进行处理。

5、无需额外条件:

不需要使用额外的空间信号或其他辅助信息,仅依靠音频输入即可生成高质量的视频。

6、长期运动信息捕捉:

具备处理长期运动信息的能力,生成更加自然和流畅的动作。

7、高自然度和高质量:

生成的视频动作自然,与音频同步性好,看起来就像真人在说话。

Loopy的技术原理:

1、音频驱动模型:

Loopy的核心是音频驱动的视频生成模型,根据输入的音频信号生成与音频同步的动态视频。

2、扩散模型:

Loopy使用扩散模型技术,通过逐步引入噪声并学习逆向过程来生成数据。

3、时间模块:

Loopy设计了跨片段和片段内部的时间模块,模型能理解和利用长期运动信息,生成更加自然和连贯的动作。

4、音频到潜空间的转换:

Loopy通过音频到潜空间的模块将音频信号转换成能够驱动面部动作的潜在表示。

5、运动生成:

从音频中提取的特征和长期运动信息,Loopy生成相应的面部动作,如嘴型、眉毛、眼睛等部位的动态变化。

Loopy应用场景:

1、虚拟主播和虚拟偶像:

根据主播的声音生成与其匹配的动画,使虚拟角色更加生动逼真。

2、电影和动画制作:

减少手动动画制作的工作量,通过音频输入生成自然的面部表情和动作

3、内容创作与短视频制作:

创作者可以利用 Loopy 为短视频或其他内容生成个性化的虚拟人物动画

4、游戏角色动画:

提升角色互动的自然感和玩家的沉浸感

5、虚拟会议和社交场景:

为用户提供真实感更强的虚拟形象,自动根据音频生成动作

6、教育和在线培训:

为在线教育平台提供虚拟教师形象,使教师的音频讲解与虚拟形象的动作自然同步

数据统计

特别声明&浏览提醒

本站AI工具导航站提供的「Loopy」的相关内容都来源于网络,不保证外部链接的准确性和完整性。在2025年02月01日 19时46分20秒收录时,该网站上的内容都属于合规合法,后期网站的内容如出现违规,可以直接联系网站管理员(ai@ipkd.cn)进行删除,AI工具导航站不承担任何责任。在浏览网页时,请注意您的账号和财产安全,切勿轻信网上广告!

6款热门AI图片生成工具,国内外智能创作神器!

6款热门AI图片生成工具,国内外智能创作神器! 全能ai翻译软件哪个好用,这8个工具突破语言障碍

全能ai翻译软件哪个好用,这8个工具突破语言障碍 6款免费AI Logo生成器,快速打造专业品牌标志!

6款免费AI Logo生成器,快速打造专业品牌标志! 多款免费AI声音克隆工具,精准复刻音色,你也可以当主播

多款免费AI声音克隆工具,精准复刻音色,你也可以当主播 盘点8款高效AI搜索工具,助力智能信息检索

盘点8款高效AI搜索工具,助力智能信息检索 亚马逊全球网点布局大盘点(包括所有开店流程)

亚马逊全球网点布局大盘点(包括所有开店流程) 11款免费AI翻译工具,一键开启高效翻译模式!

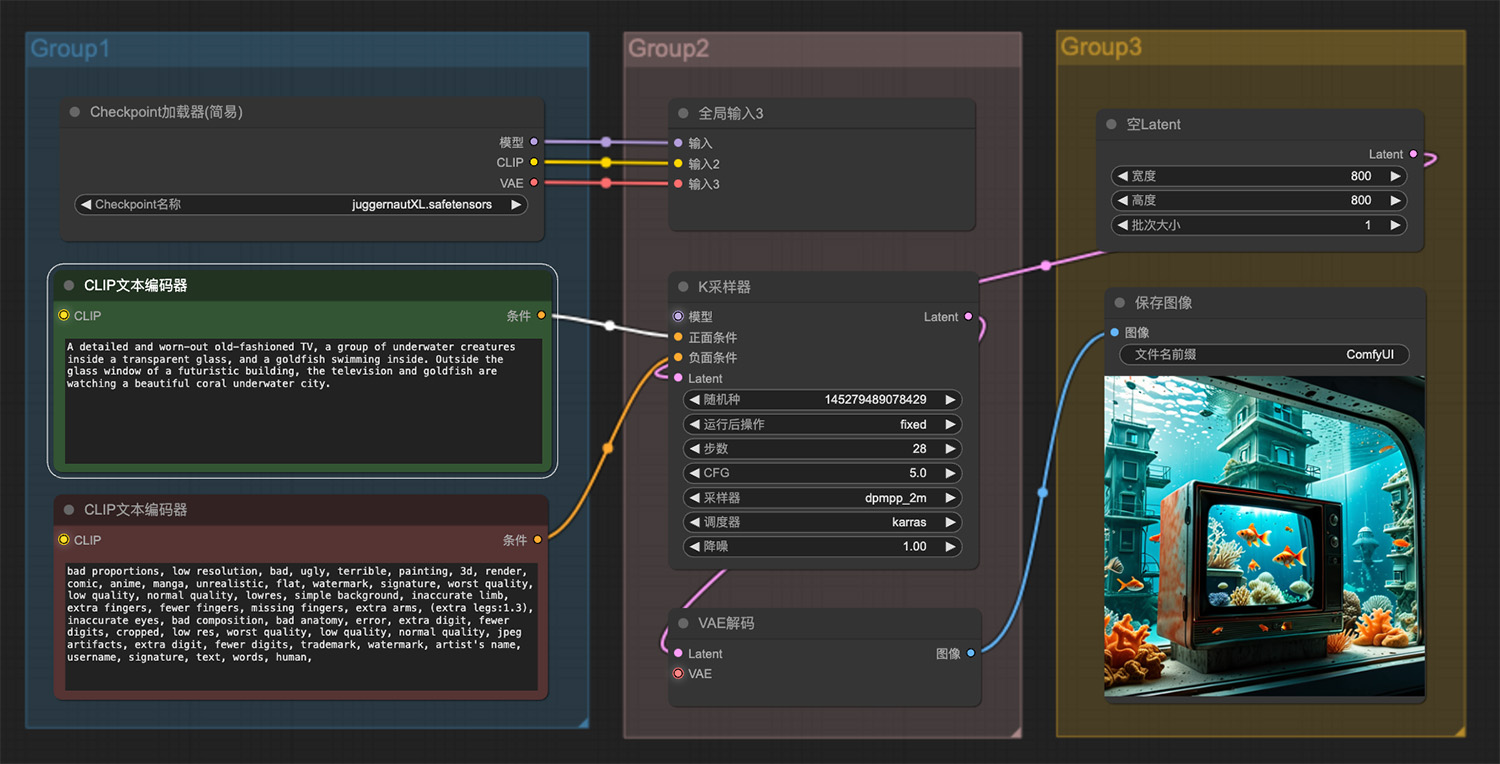

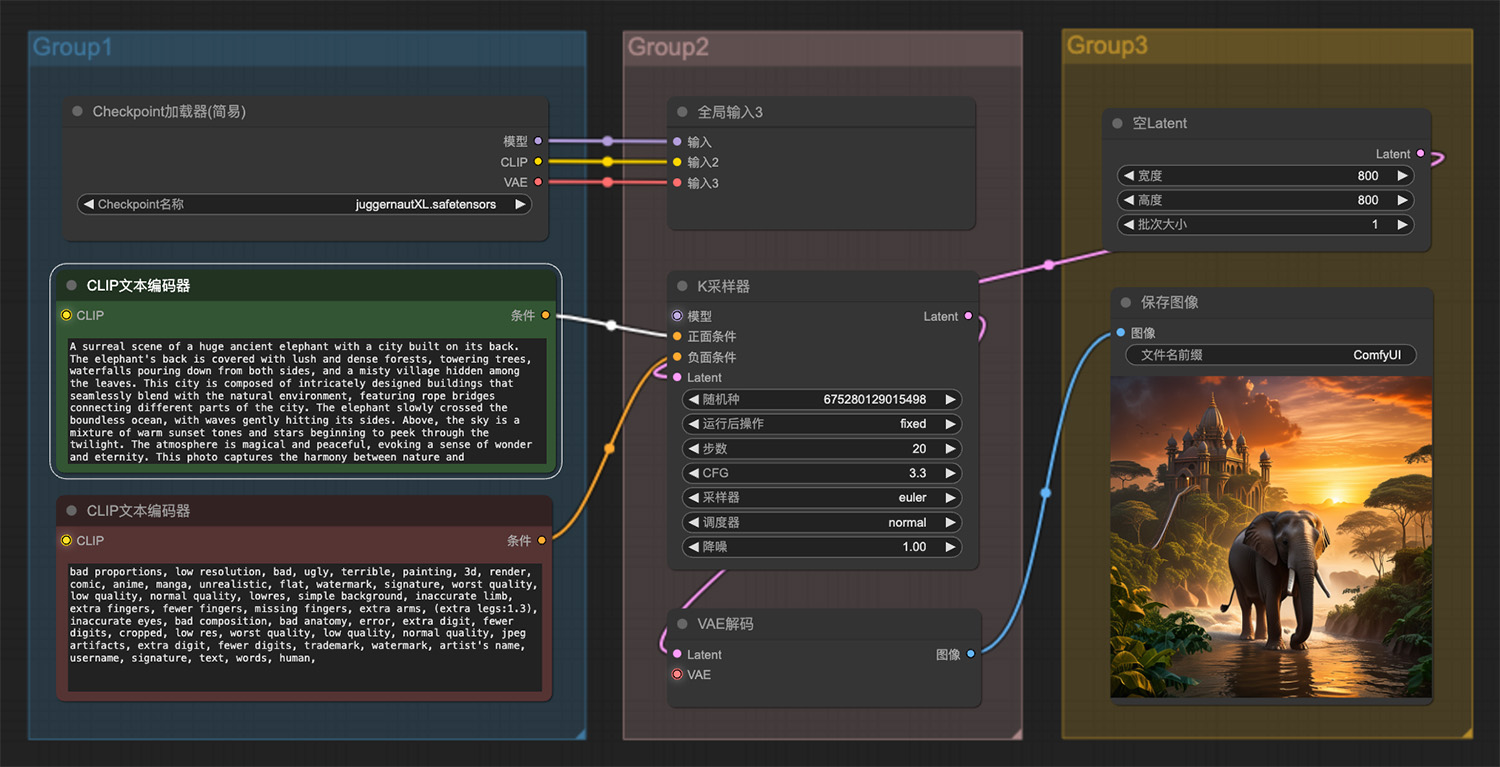

11款免费AI翻译工具,一键开启高效翻译模式! 水中一台精致而破旧的老式电视鱼缸ComfyUI工作流

水中一台精致而破旧的老式电视鱼缸ComfyUI工作流 三阶放大comfyui工作流

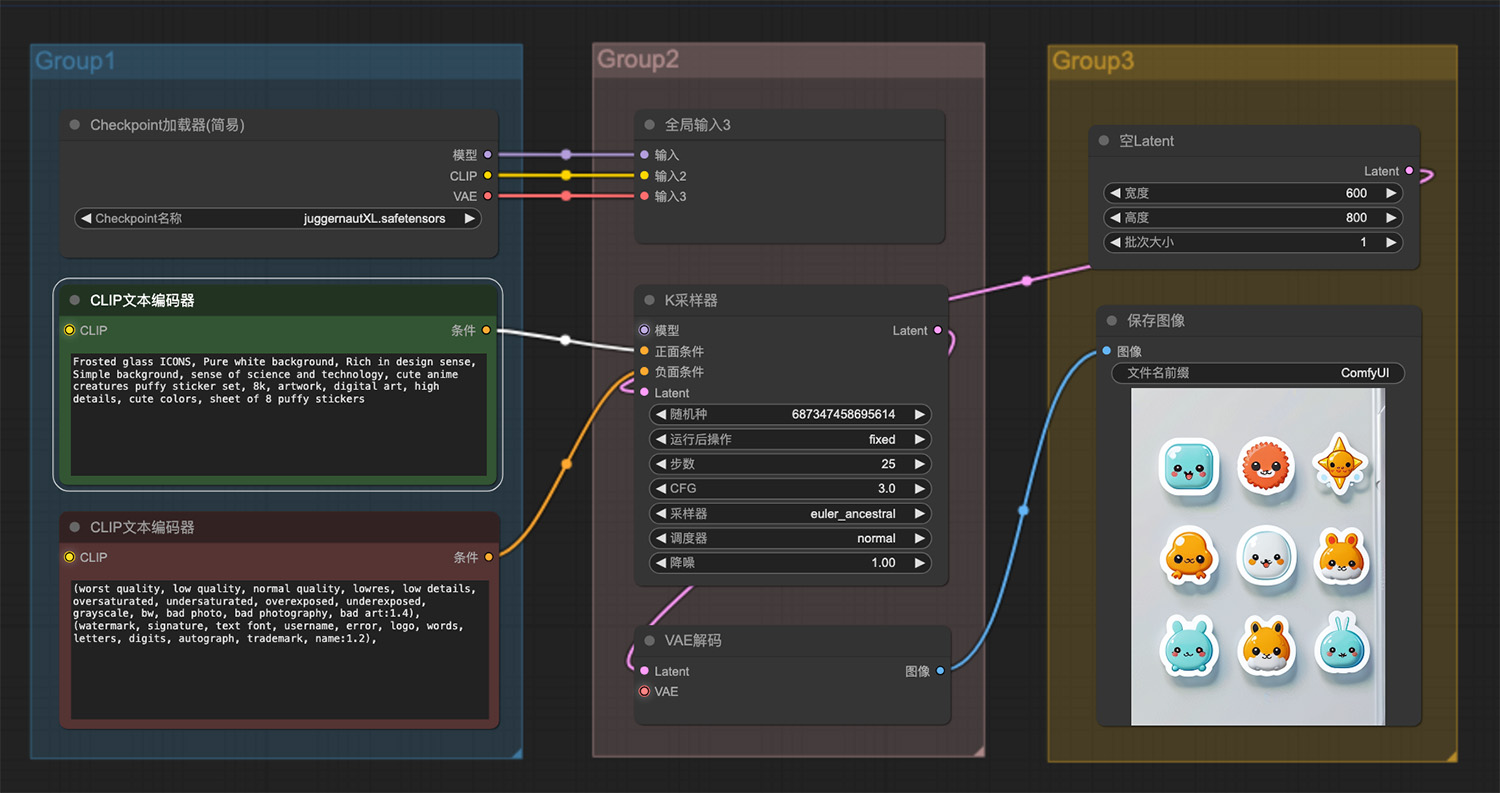

三阶放大comfyui工作流 一套可爱的动漫生物蓬松贴纸图标

一套可爱的动漫生物蓬松贴纸图标 一匹热血沸腾的汗血宝马庄严地站立着ComfyUI工作流

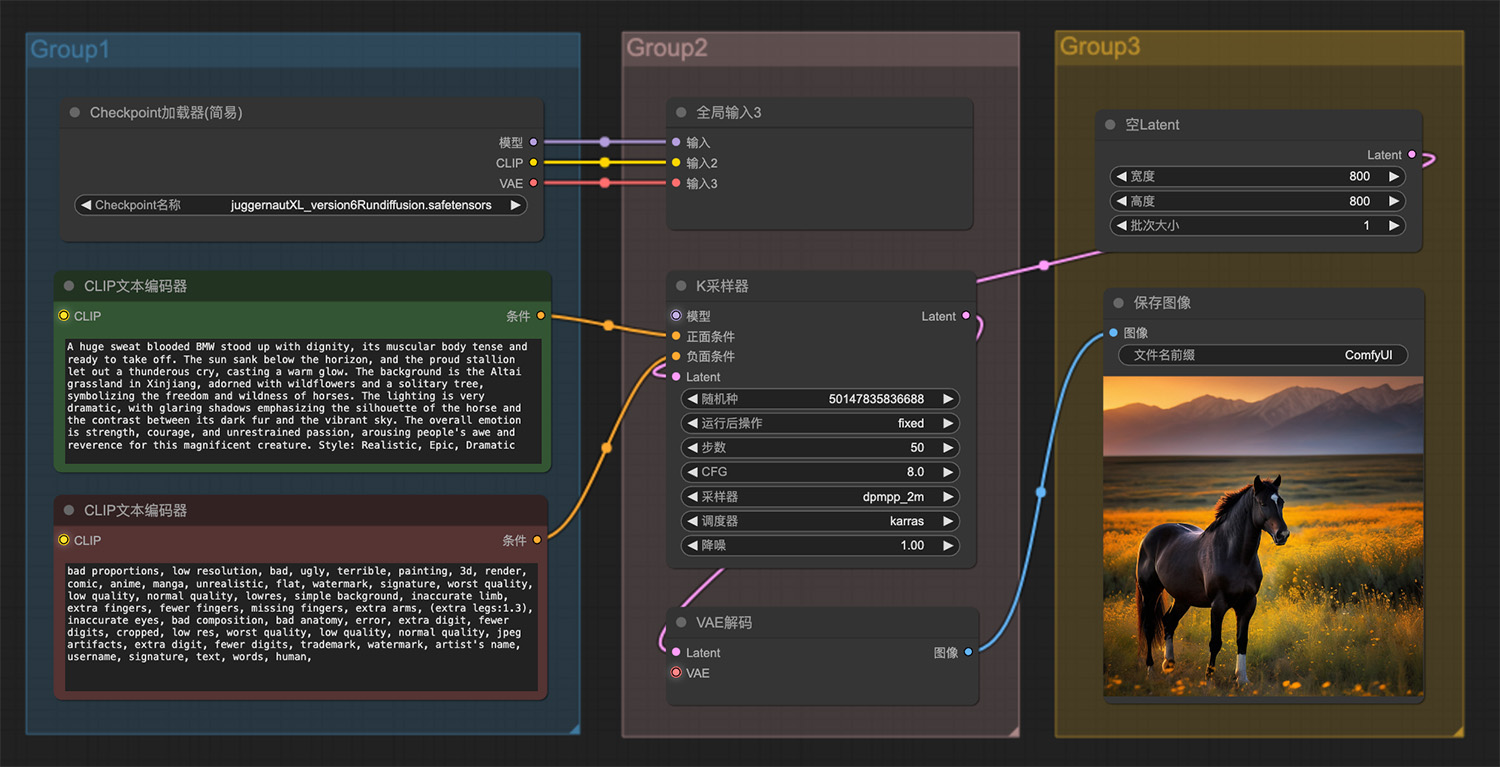

一匹热血沸腾的汗血宝马庄严地站立着ComfyUI工作流 一张皮卡丘向观众眨眼的逼真照片ComfyUI工作流

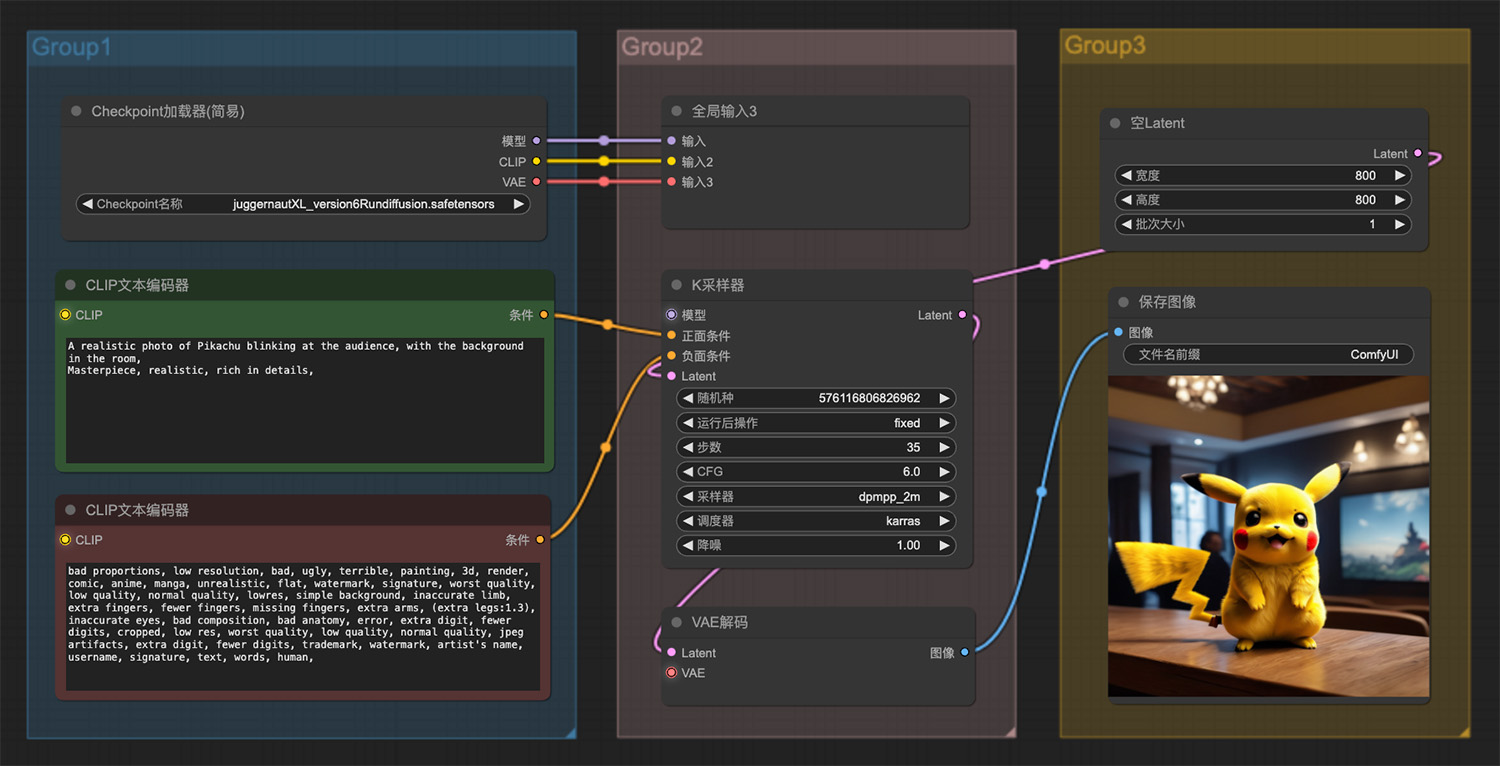

一张皮卡丘向观众眨眼的逼真照片ComfyUI工作流 一群可爱的小老鼠ComfyUI工作流

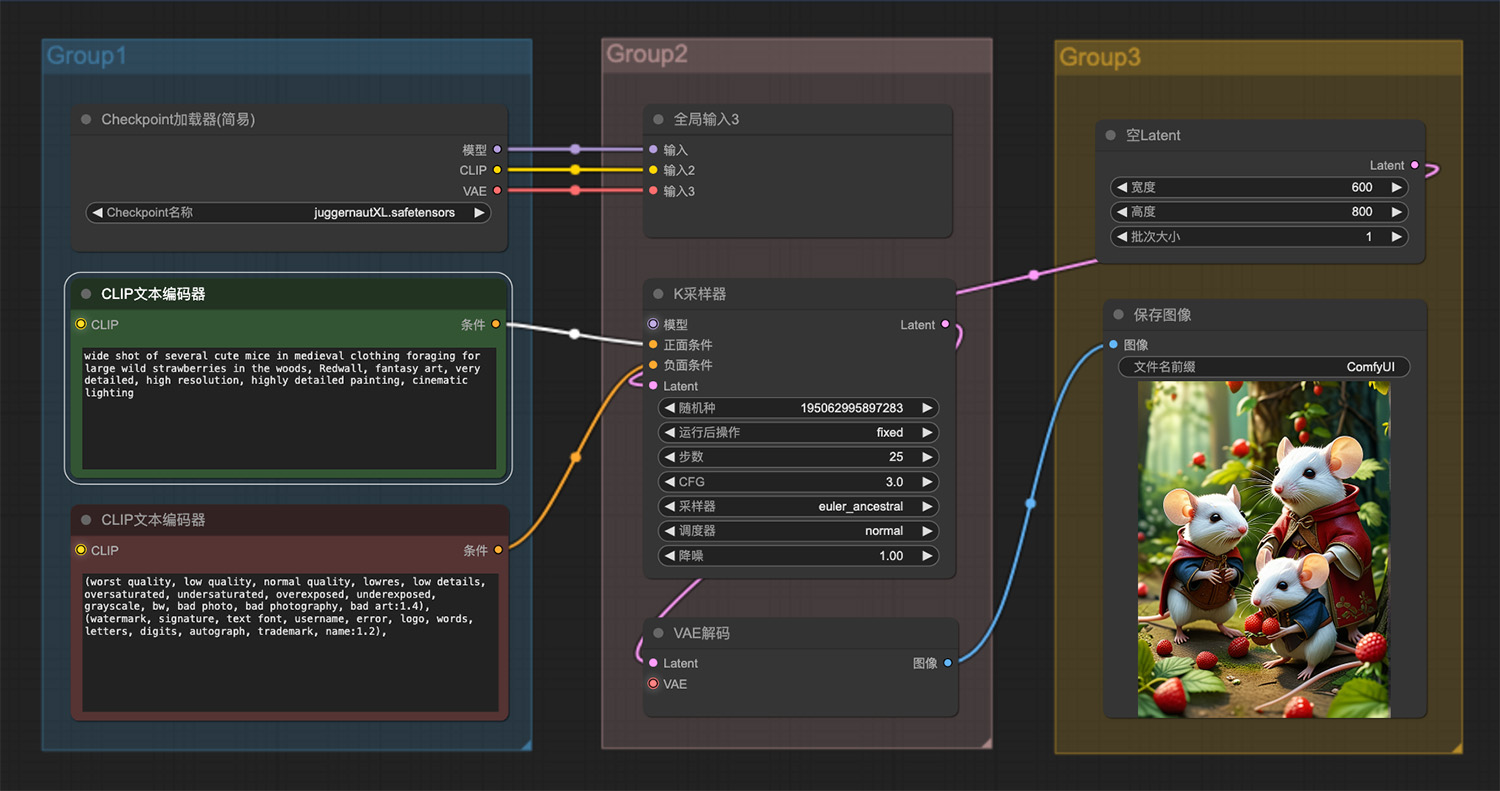

一群可爱的小老鼠ComfyUI工作流 一头巨大的古代大象背后建着一座城市

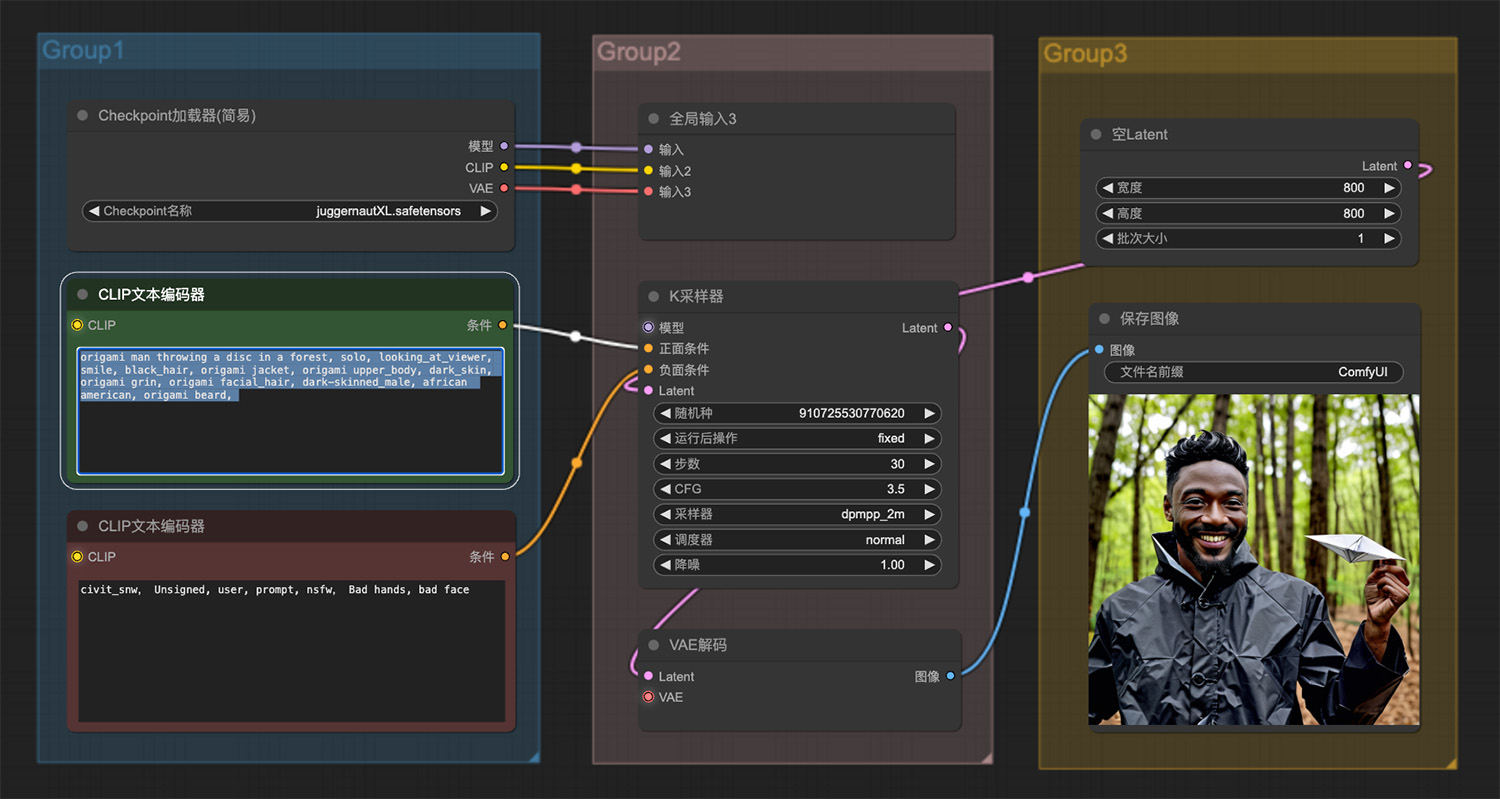

一头巨大的古代大象背后建着一座城市 一个黑人在森林中穿着折纸的衣服ComfyUI工作流

一个黑人在森林中穿着折纸的衣服ComfyUI工作流 即梦AI绘画网页版

即梦AI绘画网页版 Deepswap

Deepswap PIKA LABS

PIKA LABS AI拥抱生成器

AI拥抱生成器 FlexClip

FlexClip ProPainter

ProPainter 快转字幕

快转字幕

豆包在线网页版

豆包在线网页版 Oxolo

Oxolo 万兴播爆

万兴播爆 腾讯云AI绘画

腾讯云AI绘画 VeoGo AI

VeoGo AI SkyReels

SkyReels