UI-TARS:字节跳动开发的一种新型 GUI 代理模型

UI-TARS是一个基于视觉语言模型(VLM)的智能体,能够通过感知、推理、行动和记忆等能力,实现对图形用户界面(GUI)的端到端自动化交互。它整合了感知、推理、定位和记忆等关键组件,无需预定义工作流程或手动规则,适用于多种自动化场景,如软件测试、办公自动化、网页自动化和智能客服等。

UI-TARS功能特点:

1. 全面的GUI理解:UI-TARS支持多模态输入(文本、图像、交互),能够实时理解动态界面内容,并构建界面的连贯理解。

2. 实时交互与反馈:模型能够持续监控GUI动态,实时响应用户操作,并提供实时反馈。

3. 统一的动作空间:UI-TARS设计了跨平台的标准化行动定义,支持桌面、移动和Web环境的统一操作。

4. 多任务处理能力:支持多步骤任务执行,能够处理复杂的任务序列。

5. 长期和短期记忆:模型具备短期记忆(任务分解和反思)和长期记忆(历史交互记录),能够进行多步推理、错误纠正和动态适应。

6. 跨平台兼容性:支持Windows、macOS、安卓等平台,能够跨设备执行任务。

7. 自然语言交互:用户可以通过自然语言指令完成复杂的操作,如打开应用、填写表单、搜索信息等。

8. 端到端架构:UI-TARS采用端到端的设计,直接感知屏幕截图并生成有效操作,无需依赖外部框架或人工设计规则。

9. 开源与免费商用:UI-TARS基于Apache 2.0协议开源,允许开发者自由使用和改进。

10. 卓越的性能表现:在多个基准测试中超越了GPT-4o、Claude和Gemini等竞争对手,例如在VisualWebBench测试中达到82.8%的准确率。

UI-TARS应用场景:

1. 自动化办公:如自动填写表格、发送邮件、整理文档等。

2. 网页自动化:如自动登录网站、填写表单、抓取数据等。

3. 智能客服:通过自然语言与用户交互,完成任务调度。

4. 软件测试:自动化测试脚本生成与执行。

5. 设备联动:如控制手机播放音乐或搜索歌曲。

UI-TARS技术优势:

1. 增强感知能力:利用大规模GUI截图数据集,提升对界面元素的上下文感知能力。

2. 统一动作建模:将不同平台的动作映射到统一的操作集合,简化了跨平台任务的执行。

3. 系统化推理能力:支持系统1和系统2推理,能够进行深思熟虑的决策,并从错误中学习。

4. 迭代训练与在线反思:通过在线追踪和反思技术优化模型性能,使其能够适应不断变化的任务。

标签:

基金从业资格考试题库

一站式备考基金从业资格考试,收录2021-2025年模拟题库!

热门工具

热门标签

知识百科影音娱乐扩展插件创意设计办公提效pdf转换游戏平台AI法律服务AI思维导图法律咨询在线影视新媒运营电影下载AI搜索引擎AI效率提升

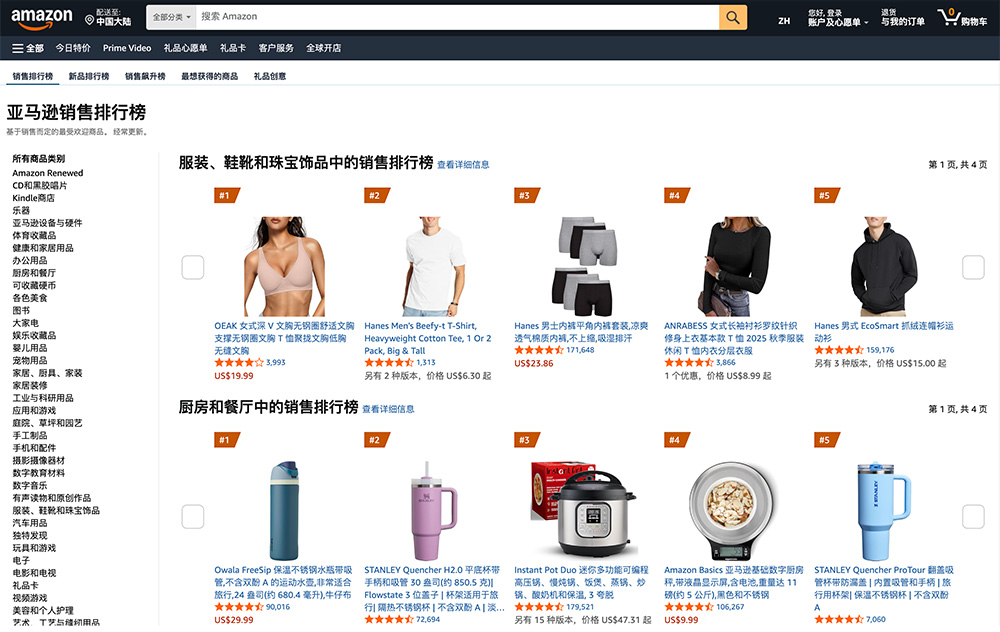

盘点亚马逊各国销售榜网址汇总

盘点亚马逊各国销售榜网址汇总 Fruugo北美跨境电商平台(盘点Fruugo北美跨境电商登录网址)

Fruugo北美跨境电商平台(盘点Fruugo北美跨境电商登录网址) Qwen3大模型系列合集,覆盖多个领域!

Qwen3大模型系列合集,覆盖多个领域! 亚马逊全球网点布局大盘点(包括所有开店流程)

亚马逊全球网点布局大盘点(包括所有开店流程) eMAG全球3大国际站大盘点

eMAG全球3大国际站大盘点 美客多全球6大国际站大盘点

美客多全球6大国际站大盘点 Comfy UI入门教程:AI绘画工作流ComfyUI搭建步骤

Comfy UI入门教程:AI绘画工作流ComfyUI搭建步骤 Seed-TTS:字节跳动开发的高质量、多功能的文本到语音(TTS)模型

Seed-TTS:字节跳动开发的高质量、多功能的文本到语音(TTS)模型 一个由谷歌提出的一种多智能体协作框架—— CoA

一个由谷歌提出的一种多智能体协作框架—— CoA 互联网最火的10个大语言模型及其应用场景全解析

互联网最火的10个大语言模型及其应用场景全解析 免费AI数据分析神器:一键生成可视化图表,轻松搞定复杂数据

免费AI数据分析神器:一键生成可视化图表,轻松搞定复杂数据 AIBox365

AIBox365 爱改写

爱改写 roop

roop Job In Corner

Job In Corner EndlessVN

EndlessVN