MoBA:一款提高大型语言模型(LLMs)处理长上下文任务的效率

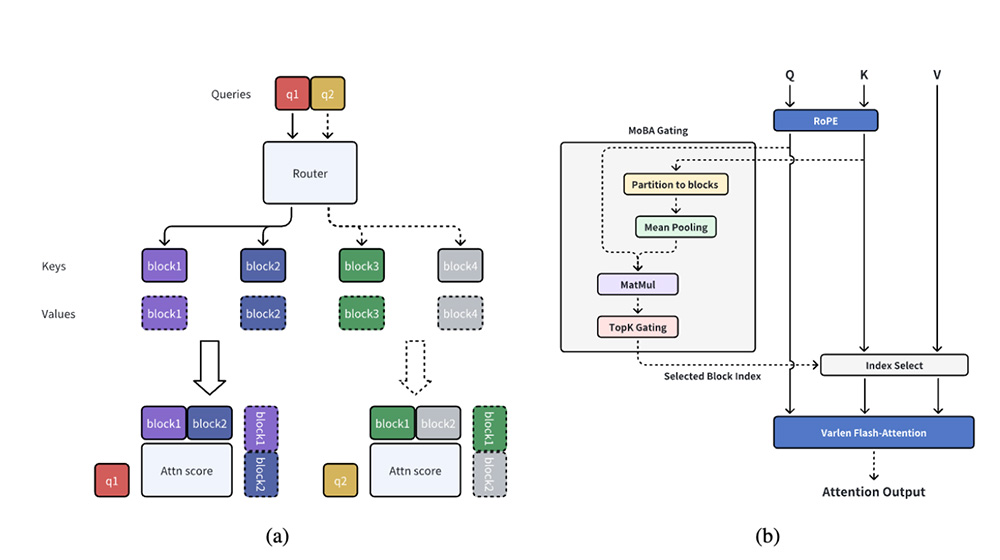

MoBA(Mixture of Block Attention)是由 Moonshot AI 提出的一种新型注意力机制,旨在提高大型语言模型(LLMs)处理长上下文任务的效率。MoBA 通过将上下文划分为多个块(block),并引入无参数的 top-k 门控机制,让每个查询 token 动态选择最相关的键值(KV)块进行注意力计算,从而显著降低计算复杂度,同时保持与传统全注意力机制相当的性能。

MoBA功能特点:

1、块稀疏注意力

MoBA 将上下文划分为多个块,每个查询 token 动态选择最相关的键值(KV)块进行注意力计算,实现高效的长序列处理。

2、无参数门控机制

通过新颖的 top-k 门控机制,MoBA 为每个查询 token 动态选择最相关的块,确保模型只关注最有信息量的部分。

3、全注意力与稀疏注意力的无缝切换

MoBA 设计为全注意力的灵活替代品,能在全注意力和稀疏注意力模式之间无缝切换,提高效率而不影响性能。

4、高性能实现

结合 FlashAttention 和 MoE(混合专家模型)的优化技术,MoBA 显著降低了计算复杂度。在处理 100 万 token 的长文本时,速度比传统全注意力机制快 6.5 倍,而在处理 1000 万 token 的超长文本时,速度提升可达 16 倍。

5、与现有模型的兼容性

MoBA 可以轻松集成到现有的 Transformer 模型中,无需进行大量训练调整。

6、因果性设计

为了保持自回归语言模型的因果关系,MoBA 确保查询 token 不能关注未来的块,并在当前块中应用因果掩码,避免信息泄露,同时保留局部上下文信息。

7、细粒度块划分与扩展性

MoBA 支持细粒度的块划分,类似于 MoE 中的专家划分策略,提升了性能,使其能够扩展到极长的上下文(如 1000 万 token),在长上下文任务中表现出色。

MoBA应用场景:

1、长文本处理:高效处理长文本,如历史数据分析、复杂推理和决策等任务。

2、长上下文语言模型:已部署在 Kimi 平台上,显著提升处理效率。

3、多模态任务:扩展到多模态任务中,处理和理解多种类型的数据。

4、个人助理与智能家居:高效处理用户的长指令,提升用户体验。

5、教育与学习:帮助学生处理长篇学习资料,辅助完成作业。

6、复杂推理与决策:高效处理复杂的推理任务,同时保持与全注意力机制相当的性能。

MoBA项目地址:

1、Github仓库:https://github.com/MoonshotAI/MoBA

2、技术论文:https://github.com/MoonshotAI/MoBA

标签:

基金从业资格考试题库

一站式备考基金从业资格考试,收录2021-2025年模拟题库!

热门工具

热门标签

前端UI组件库PDF分析大语言模型AI写真法律咨询AI头像绘制短剧资源ChatGPT下载中心AI图像处理教师必备谷歌插件文字工具游戏平台3D模型

盘点亚马逊各国销售榜网址汇总

盘点亚马逊各国销售榜网址汇总 Fruugo北美跨境电商平台(盘点Fruugo北美跨境电商登录网址)

Fruugo北美跨境电商平台(盘点Fruugo北美跨境电商登录网址) Qwen3大模型系列合集,覆盖多个领域!

Qwen3大模型系列合集,覆盖多个领域! 亚马逊全球网点布局大盘点(包括所有开店流程)

亚马逊全球网点布局大盘点(包括所有开店流程) eMAG全球3大国际站大盘点

eMAG全球3大国际站大盘点 美客多全球6大国际站大盘点

美客多全球6大国际站大盘点 Seed-TTS:字节跳动开发的高质量、多功能的文本到语音(TTS)模型

Seed-TTS:字节跳动开发的高质量、多功能的文本到语音(TTS)模型 Comfy UI入门教程:AI绘画工作流ComfyUI搭建步骤

Comfy UI入门教程:AI绘画工作流ComfyUI搭建步骤 一个由谷歌提出的一种多智能体协作框架—— CoA

一个由谷歌提出的一种多智能体协作框架—— CoA 免费AI数据分析神器:一键生成可视化图表,轻松搞定复杂数据

免费AI数据分析神器:一键生成可视化图表,轻松搞定复杂数据 互联网最火的10个大语言模型及其应用场景全解析

互联网最火的10个大语言模型及其应用场景全解析 爱改写

爱改写 EndlessVN

EndlessVN roop

roop Job In Corner

Job In Corner AIBox365

AIBox365