UltraMem:字节旗下豆包大模型团队推出的一种稀疏模型架构

UltraMem是一种创新的稀疏模型架构,通过优化计算与参数解耦,显著提升了推理速度和内存访问效率。其核心设计思想是将计算过程与参数管理分离,从而减少不必要的内存操作,降低内存依赖,并提高资源利用率。

UltraMem在推理速度上相比传统的Mixture of Experts(MoE)架构提升了2至6倍,同时将推理成本降低了最高达83%。这一突破性进展使其成为解决大规模模型推理瓶颈的重要技术手段。

UltraMem功能特点:

1. 推理速度提升

UltraMem通过优化访存机制和动态路由算法,显著提升了推理速度。实验表明,在相同计算资源下,UltraMem的推理速度是传统MoE架构的2至6倍。

2. 成本降低

UltraMem将推理成本降低了最高达83%,这使得大规模模型的部署和运行更加经济高效。

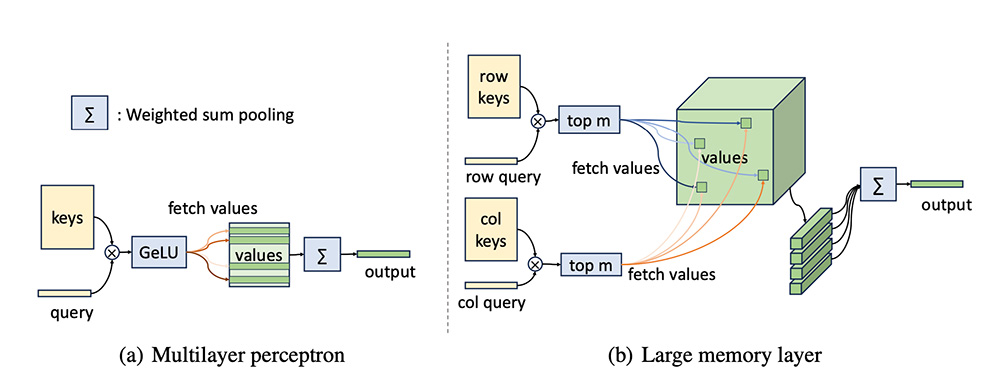

3. 内存访问优化

UltraMem通过稀疏编码和选择性参数激活策略,减少了需要访问的参数数量,从而降低了内存依赖。此外,其分层存储结构和动态路由算法进一步优化了内存访问效率。

4. 模型扩展性

UltraMem展示了优异的Scaling Law,表明其在大规模模型训练中具有良好的扩展性。实验显示,UltraMem在训练规模达到2000万value时,仍能保持领先的推理速度和模型性能。

5. 高效稀疏化设计

UltraMem采用了多层memory layer的设计,并引入了skip-layer操作,使得模型能够更高效地进行内存访问和计算任务的并行处理。

6. 性能超越MoE

在相同激活条件和参数下,UltraMem在性能上超越了MoE架构。实验结果显示,UltraMem在推理速度和内存访问效率方面均优于MoE。

7. 广泛的应用潜力

UltraMem不仅在自然语言处理领域表现出色,还在自动驾驶、医疗影像识别、金融风控等多个领域展现了广阔的应用前景。

8. 技术创新

UltraMem结合了Tucker分解、隐式扩展稀疏参数等技术,进一步提升了值检索的准确性和模型性能。

UltraMem应用场景:

UltraMem已经在AI绘画、写作工具等生成式AI应用中得到了验证。其优化后的推理能力显著提高了生成高质量图像和文本的速度和资源效率。此外,UltraMem还被应用于推荐系统、自然语言处理和自动驾驶等领域,展现了其在实际场景中的强大适应性和高效性。

标签:

基金从业资格考试题库

一站式备考基金从业资格考试,收录2021-2025年模拟题库!

热门工具

热门标签

思维导图影视下载短剧搜索学习资源影音娱乐批量处理创意设计AI抠图AI大模型学术论文AI法律服务教师必备生活服务ChatGPTAI金融事务

盘点亚马逊各国销售榜网址汇总

盘点亚马逊各国销售榜网址汇总 Fruugo北美跨境电商平台(盘点Fruugo北美跨境电商登录网址)

Fruugo北美跨境电商平台(盘点Fruugo北美跨境电商登录网址) Qwen3大模型系列合集,覆盖多个领域!

Qwen3大模型系列合集,覆盖多个领域! 亚马逊全球网点布局大盘点(包括所有开店流程)

亚马逊全球网点布局大盘点(包括所有开店流程) eMAG全球3大国际站大盘点

eMAG全球3大国际站大盘点 美客多全球6大国际站大盘点

美客多全球6大国际站大盘点 Seed-TTS:字节跳动开发的高质量、多功能的文本到语音(TTS)模型

Seed-TTS:字节跳动开发的高质量、多功能的文本到语音(TTS)模型 一个由谷歌提出的一种多智能体协作框架—— CoA

一个由谷歌提出的一种多智能体协作框架—— CoA Comfy UI入门教程:AI绘画工作流ComfyUI搭建步骤

Comfy UI入门教程:AI绘画工作流ComfyUI搭建步骤 互联网最火的10个大语言模型及其应用场景全解析

互联网最火的10个大语言模型及其应用场景全解析 免费AI数据分析神器:一键生成可视化图表,轻松搞定复杂数据

免费AI数据分析神器:一键生成可视化图表,轻松搞定复杂数据 爱改写

爱改写 Job In Corner

Job In Corner AIBox365

AIBox365 roop

roop EndlessVN

EndlessVN