-

- AI创新应用Caffe它采用“配置文件即代码”理念:网络结构、训练超参全部写在`.prototxt`里,一条命令即可完成训练或部署,曾被广泛用于学术竞赛(ILSVRC)与工业落地。

爱站权重:

Caffe(Convolutional Architecture for Fast Feature Embedding)由UC伯克利BVLC实验室2014年开源,用C++编写并支持CUDA,是最早专注“卷积神经网络工程化”的深度学习框架。它采用“配置文件即代码”理念:网络结构、训练超参全部写在`.prototxt`里,一条命令即可完成训练或部署,曾被广泛用于学术竞赛(ILSVRC)与工业落地。

Caffe平台特点:

1、静态图+声明式配置:

网络拓扑、数据层、损失函数均在`*.prototxt`中描述,无需写前向/反向代码;版本管理友好,适合工程复现。

2、高效C++/CUDA实现:

核心算子手写CUDA,支持cuDNN、BLAS;在2015即实现1-GPU一天训完AlexNet,推理速度同期领先。

3、模块化Layer-Blob-Net架构:

Blob存储张量+梯度;Layer封装前向/反向;Net负责拓扑拼接;新增算子只需继承Layer类并注册。

4、跨平台轻量部署:

纯C++依赖少,可交叉编译到ARM、x86、FPGA;OpenCV-DNN、TensorRT、Intel OpenVINO均原生支持Caffe模型转换。

5、丰富的Model Zoo:

官方与社区提供100+预训练模型:AlexNet、VGG、GoogLeNet、ResNet、SSD、FCN、DeepLab等,下载即用。

6、多接口与语言绑定:

提供Python、Matlab、命令行三件套;训练阶段可用Python脚本动态生成prototxt,推理阶段仅链接C++库即可。

Caffe典型应用场景:

1、图像分类/检索:

电商、图库、安检机利用预训练CNN提取4096-d特征,再建Faiss索引实现毫秒级以图搜图。

2、目标检测与定位:

SSD、Faster R-CNN的早期官方实现均基于Caffe;工业视觉用1080Ti+Caffe训SSD300,可在300ms内完成1000部件检测。

3、语义/实例分割:

FCN、DeepLabv1-v2原生prototxt发布,医疗影像公司基于此做肺/肝病灶分割,嵌入NVIDIA Jetson实现移动DR实时提示。

4、边缘与嵌入式设备:

无人机、安防摄像头将`.caffemodel`转TensorRT INT8,在Jetson Nano上运行YOLOv2-608可达15 FPS。

5、模型压缩教学:

静态图结构清晰,适合剪枝、量化、蒸馏等算法研究;多篇早期模型压缩论文(Han Song 2015)均以Caffe为基准代码。

6、传统工业质检:

3C外壳缺陷检测用小型CNN(<5MB)部署到ARM+Linux工控机,C++推理库仅2MB,启动时间<100ms,满足产线节拍。

数据统计

特别声明&浏览提醒

本站AI工具导航站提供的「Caffe」的相关内容都来源于网络,不保证外部链接的准确性和完整性。在2023年08月11日 07时45分56秒收录时,该网站上的内容都属于合规合法,后期网站的内容如出现违规,可以直接联系网站管理员(ai@ipkd.cn)进行删除,AI工具导航站不承担任何责任。在浏览网页时,请注意您的账号和财产安全,切勿轻信网上广告!

12款AI数字人制作工具,快速生成口播与直播内容!

12款AI数字人制作工具,快速生成口播与直播内容! 5款AI老照片修复工具,轻松去除图片和视频马赛克

5款AI老照片修复工具,轻松去除图片和视频马赛克 打工人开工的12款办公室ai工具

打工人开工的12款办公室ai工具 阿里巴巴旗下12款AI工具全解析:助力智能商业升级!

阿里巴巴旗下12款AI工具全解析:助力智能商业升级! 目前国内最火好用的ai视频软件有哪些 2025流行的AI视频软件排行榜

目前国内最火好用的ai视频软件有哪些 2025流行的AI视频软件排行榜 6款免费好用的AI文本转语音工具,智能合成超逼真配音

6款免费好用的AI文本转语音工具,智能合成超逼真配音 12款免费AI编程工具,智能生成代码,提升开发效率

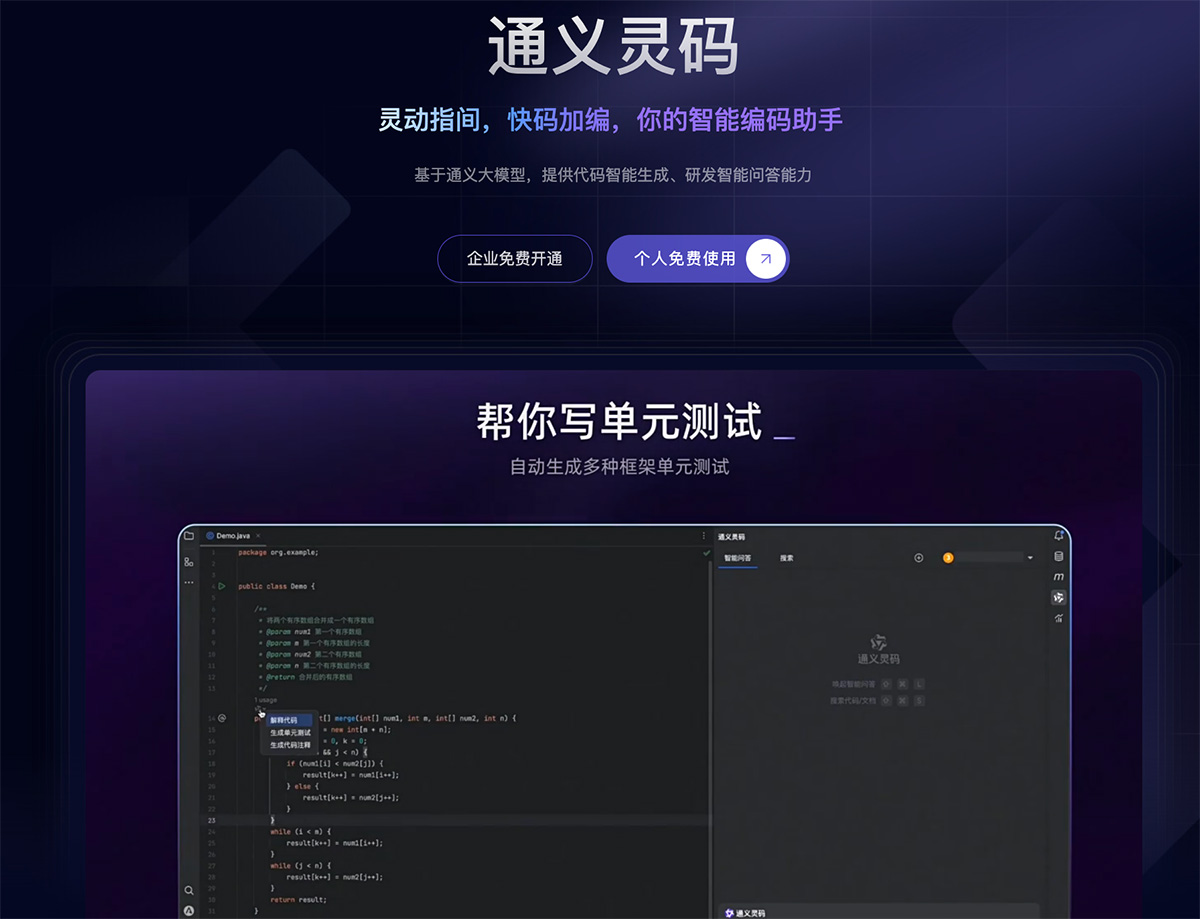

12款免费AI编程工具,智能生成代码,提升开发效率 9款免费AI智能助手,聊天机器人开启智能生活!

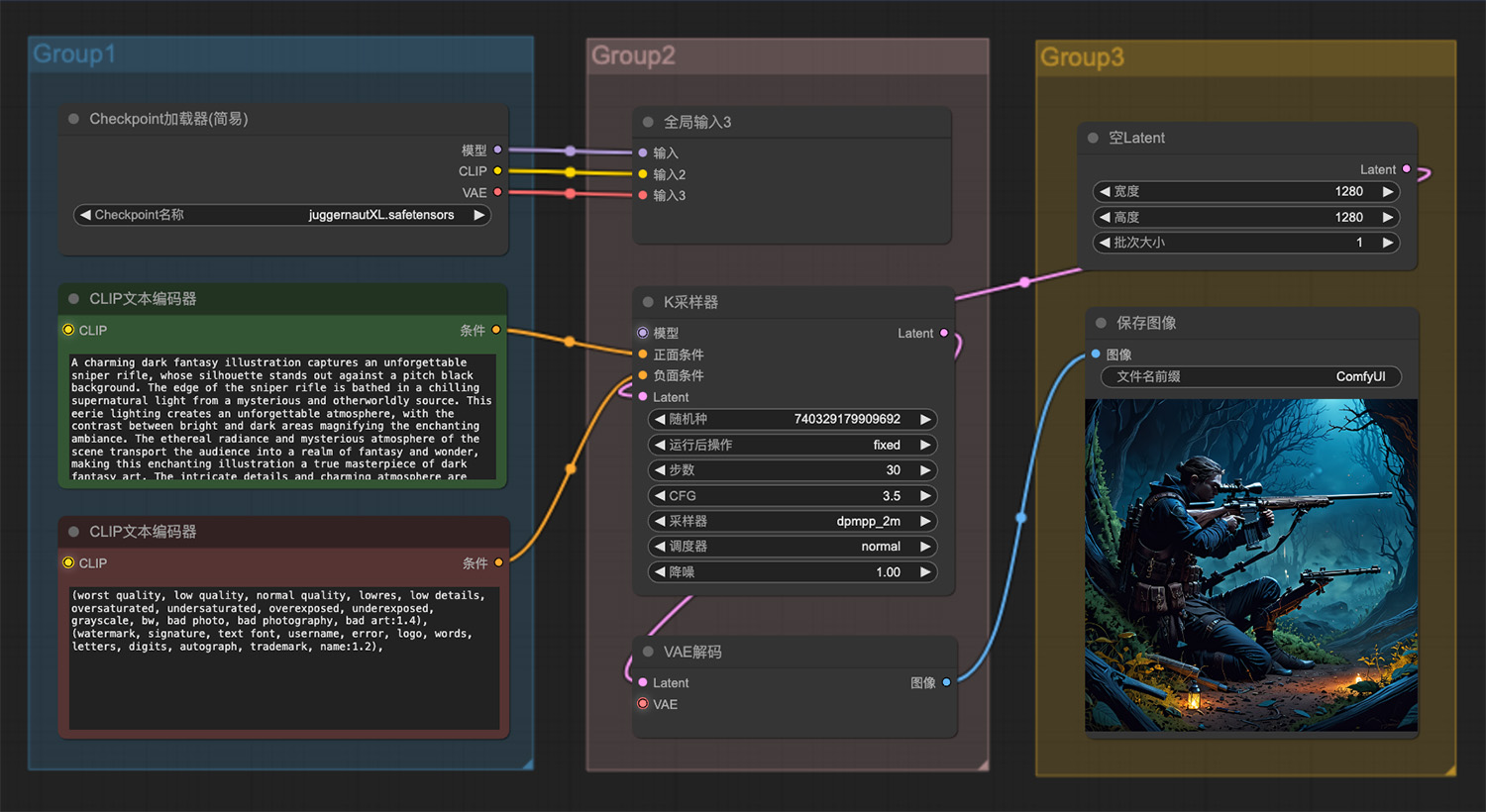

9款免费AI智能助手,聊天机器人开启智能生活! 一支令人难忘的狙击步枪ComfyUI工作流

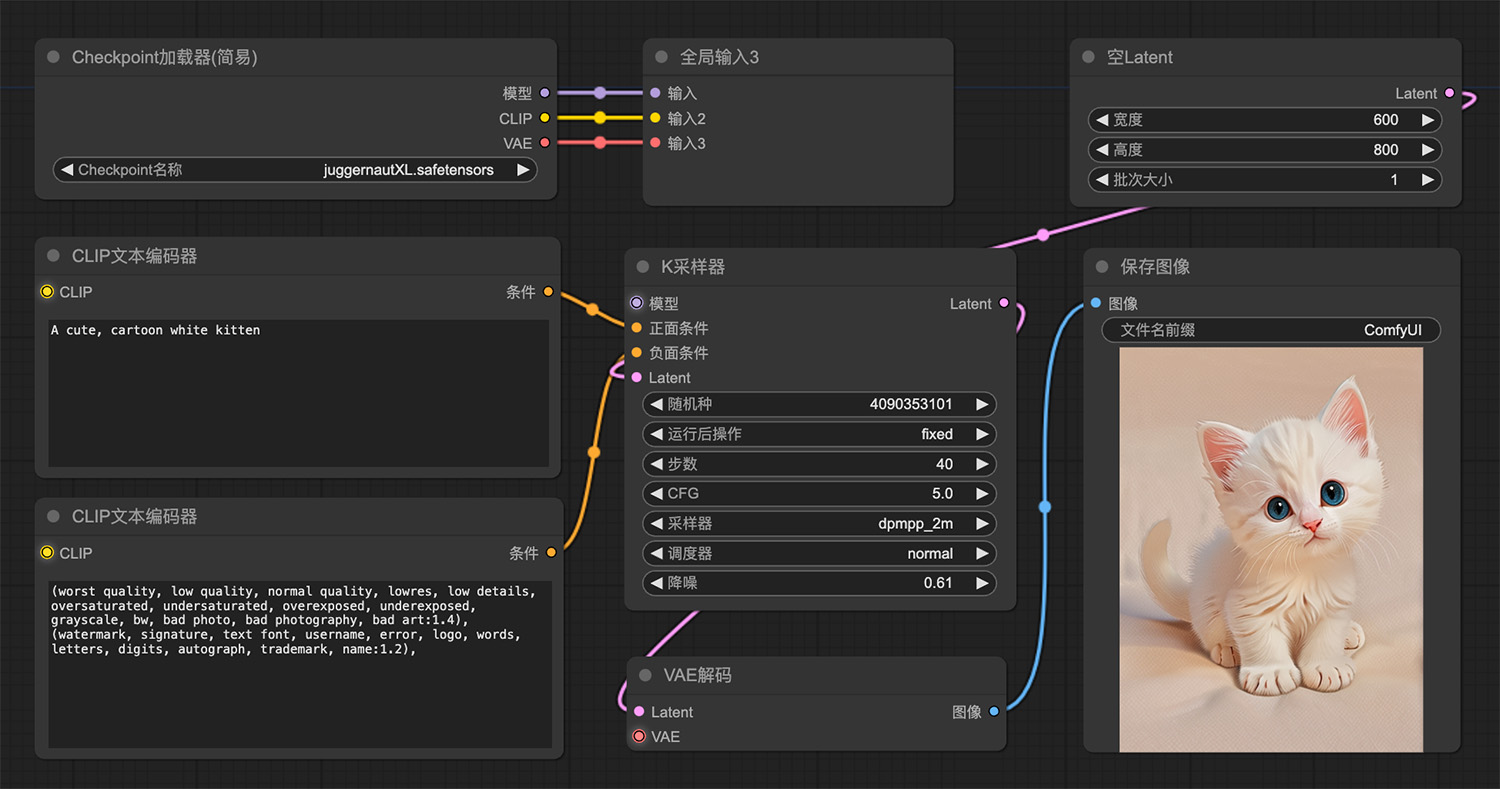

一支令人难忘的狙击步枪ComfyUI工作流 一只白色小猫comfyui工作流

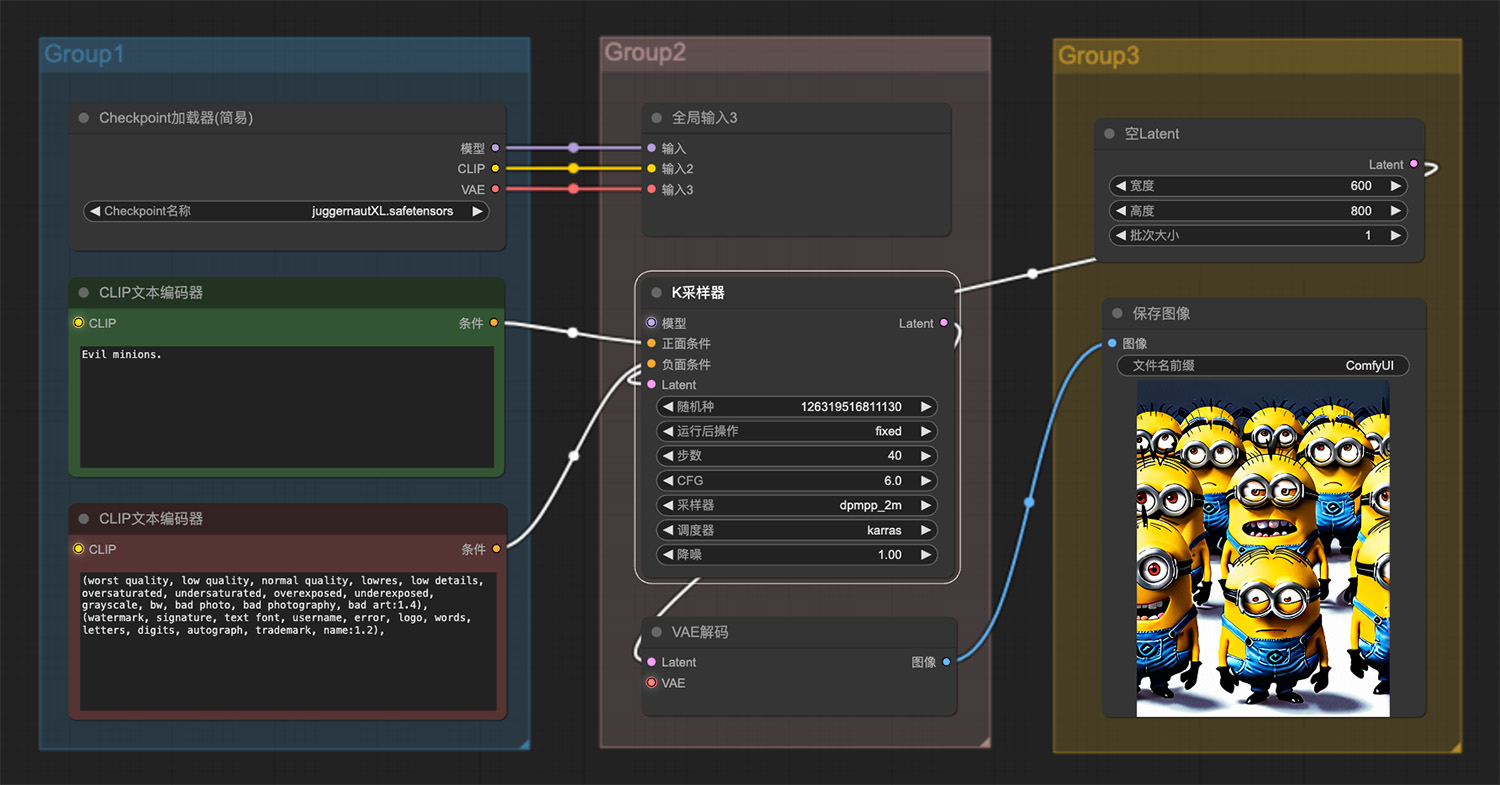

一只白色小猫comfyui工作流 一群邪恶的小黄人ComfyUI工作流

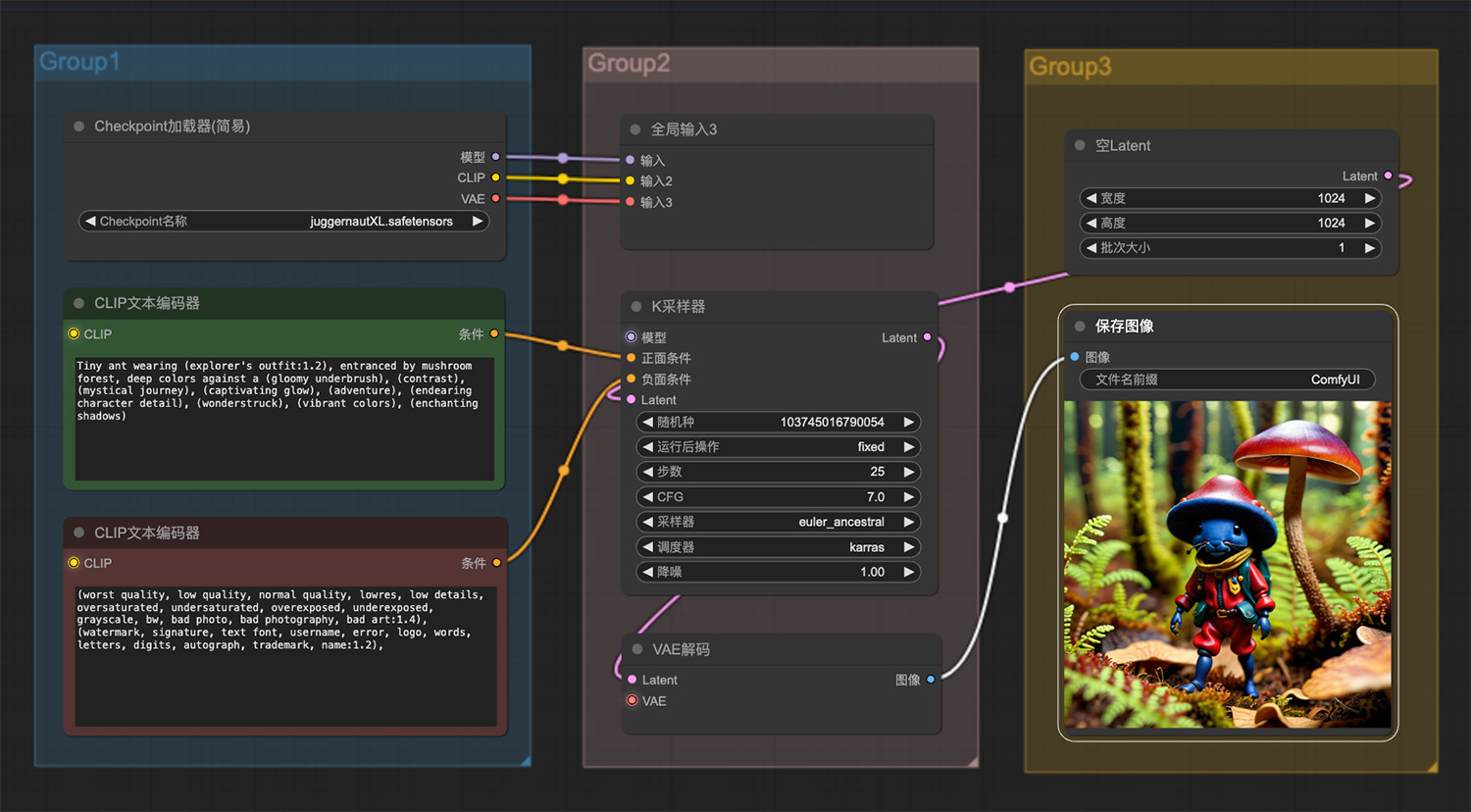

一群邪恶的小黄人ComfyUI工作流 穿着蘑菇帽的小蚂蚁探险家ComfyUI工作流

穿着蘑菇帽的小蚂蚁探险家ComfyUI工作流 文生图工作流:图片合并comfyui工作流

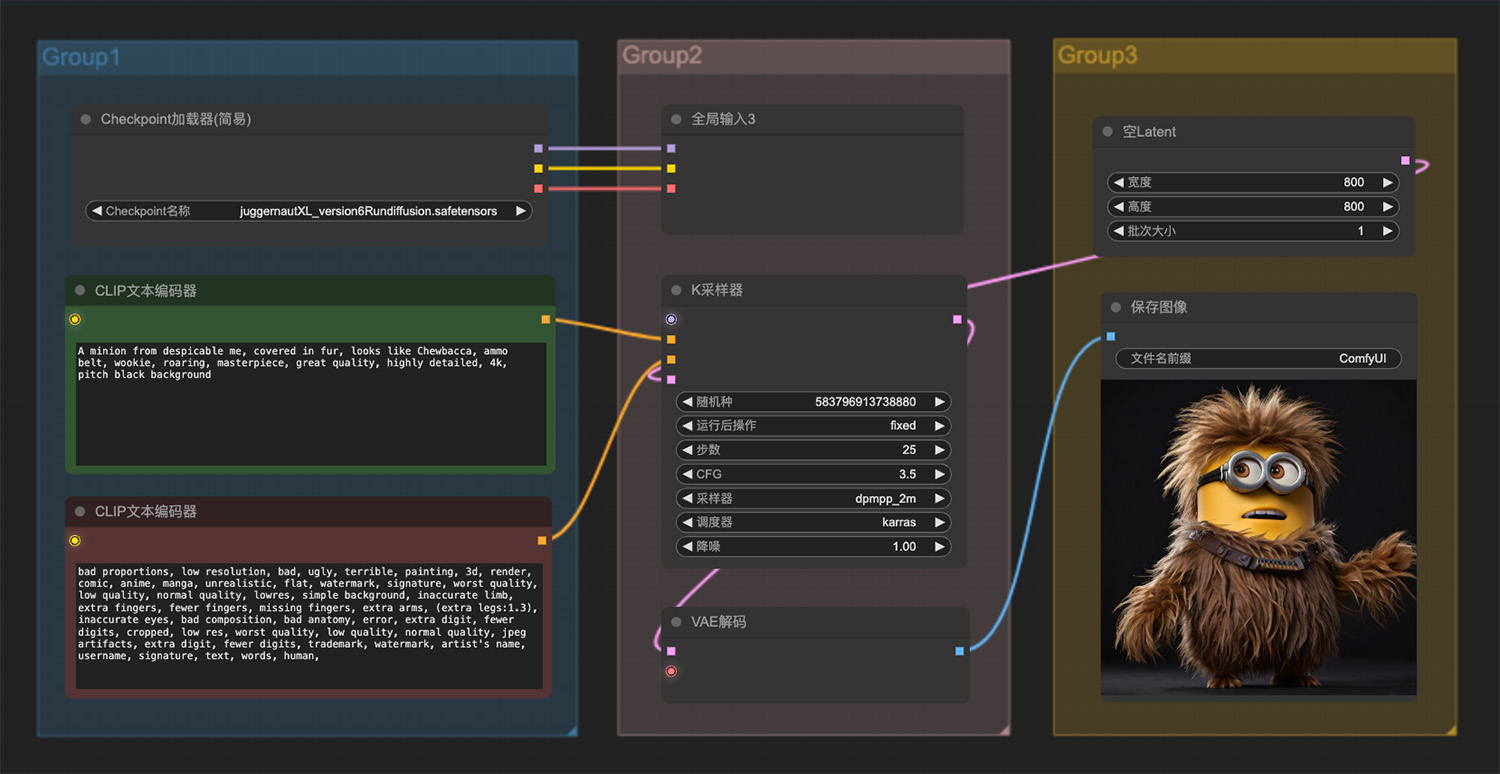

文生图工作流:图片合并comfyui工作流 一个浑身皮毛看起来像丘巴卡的3d动漫人物

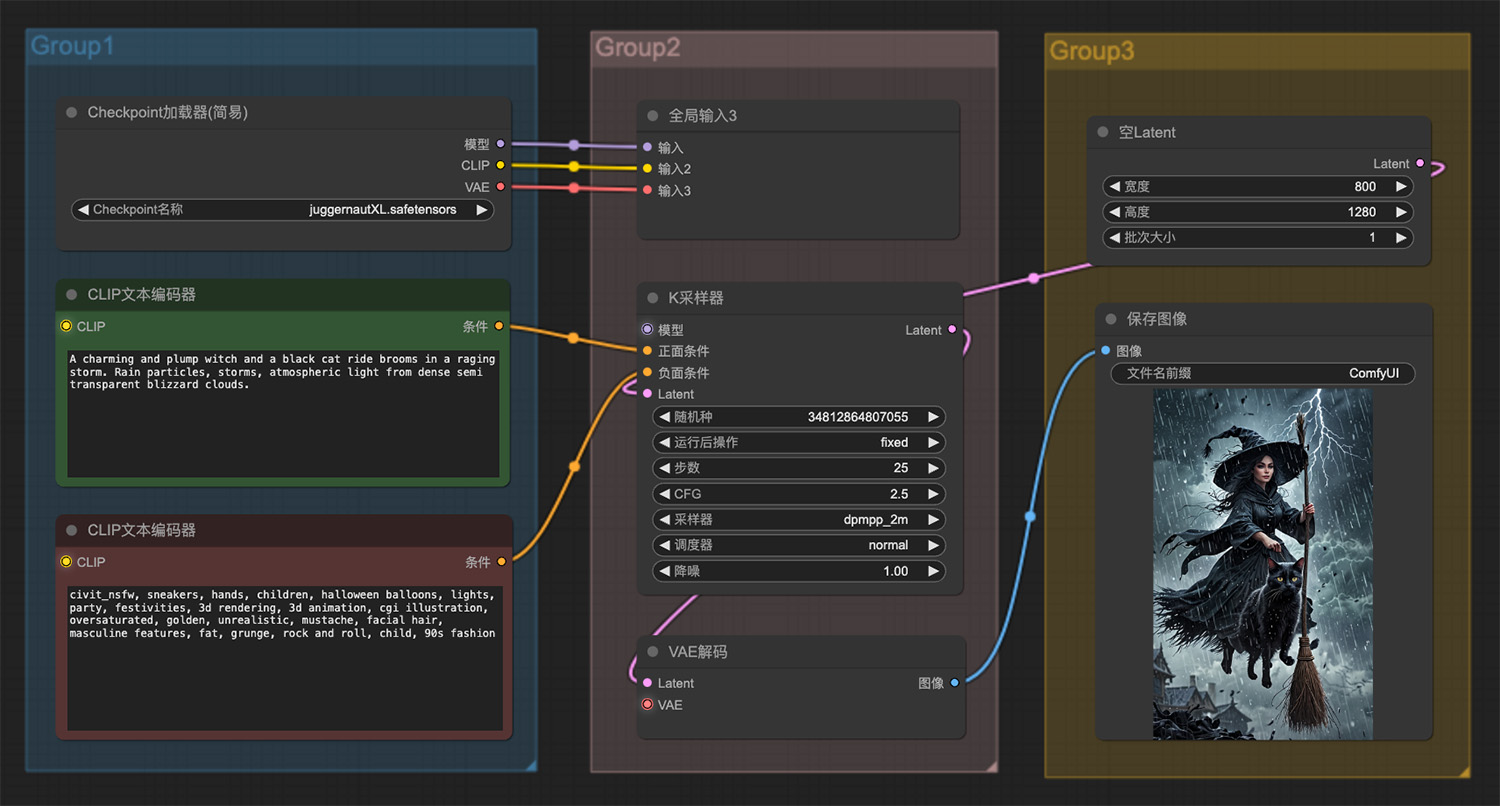

一个浑身皮毛看起来像丘巴卡的3d动漫人物 一个迷人而丰满的女巫和一只黑猫骑着飞天扫帚

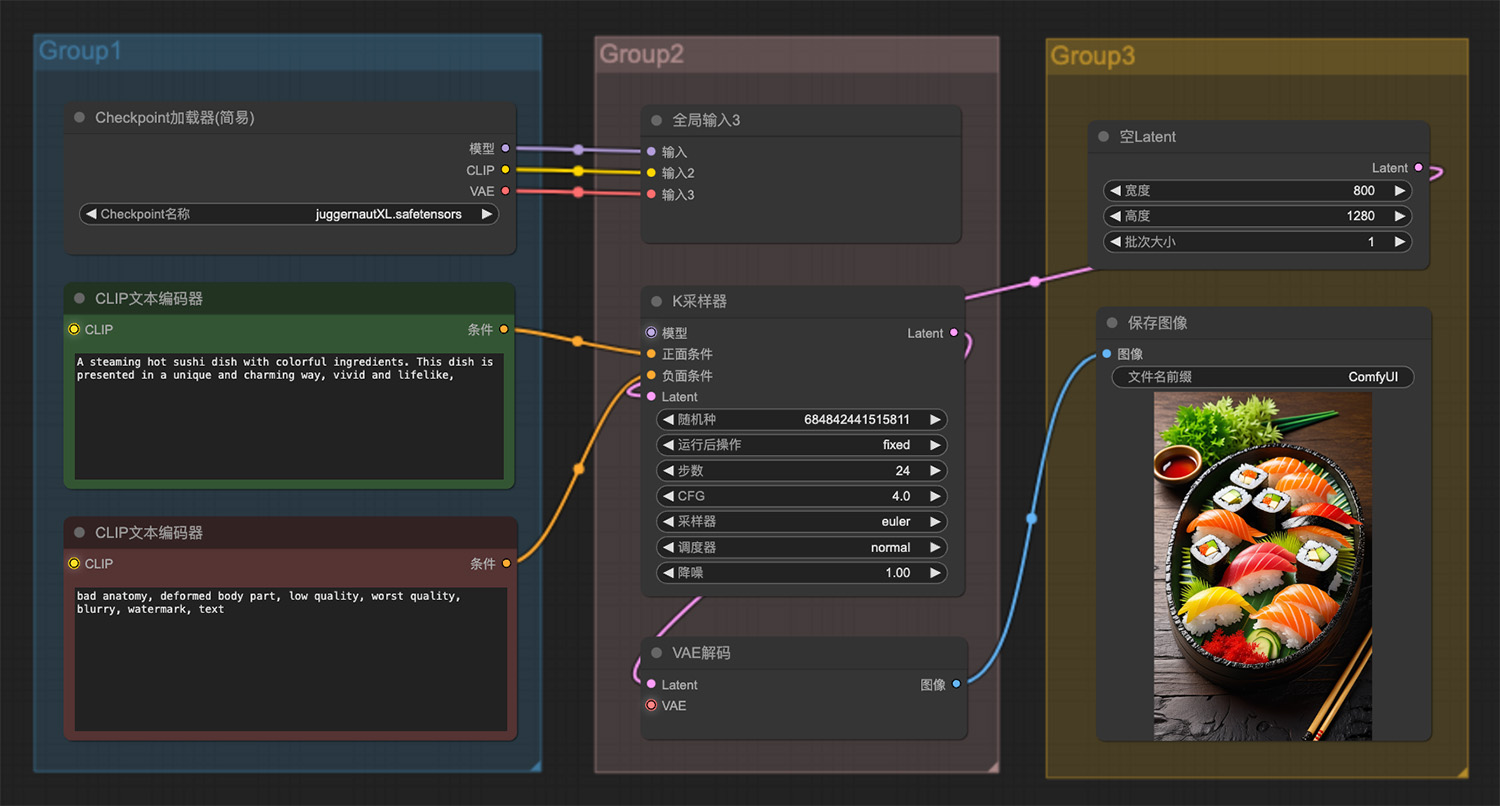

一个迷人而丰满的女巫和一只黑猫骑着飞天扫帚 一盒用五颜六色的食材烹制的热气腾腾的寿司

一盒用五颜六色的食材烹制的热气腾腾的寿司 即梦AI绘画网页版

即梦AI绘画网页版 Fireflies

Fireflies 匡优AI

匡优AI 复旦AI搜索

复旦AI搜索  Smodin AI Content Detector

Smodin AI Content Detector Originality.AI

Originality.AI 知网AI智能备课

知网AI智能备课

豆包在线网页版

豆包在线网页版 功夫量化

功夫量化 FP Alpha

FP Alpha Yazone地带

Yazone地带 ChatGAi

ChatGAi Winston AI

Winston AI